Algorithmes éthiques en santé : un défi technologique et sociétal

Les possibilités offertes par les algorithmes et l’intelligence artificielle dans le domaine de la santé soulèvent de nombreuses questions. Quels sont les risques liés à leur utilisation ? Comment s’assurer qu’ils auront un impact positif pour le patient au plan individuel ? Quels garde-fous faut-il mettre en place pour garantir le respect des valeurs de notre système de santé ?

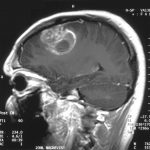

Watson, le supercalculateur d’IBM, s’est attaqué il y a quelques années au secteur de la santé et notamment de l’oncologie. Il a ouvert la voie à des centaines de solutions numériques, allant des algorithmes d’analyse d’images radiologiques aux programmes plus complexes destinés à aider les médecins dans leurs décisions thérapeutiques. Les spécialistes s’accordent sur la révolution que ces outils vont provoquer en médecine, mais des inquiétudes légitimes surgissent. La CNIL signale notamment dans son rapport sur les enjeux éthiques des algorithmes et de l’intelligence artificielle qu’ils « peuvent susciter des biais, des discriminations, voire des formes d’exclusion ».

Dans le domaine de la bioéthique, quatre principes de base ont été énoncés en 1978 : la justice, l’autonomie, la bienfaisance, et la non-malfaisance. Ces principes guident la réflexion sur les problèmes éthiques posés par les nouveaux usages du numérique. Christine Balagué, titulaire de la chaire réseaux sociaux et IoT à Institut Mines-Télécom Business School, souligne cependant un écueil : « la question de l’éthique est d’abord liée aux valeurs d’une culture. La Chine et la France par exemple n’ont pas fait les mêmes choix en termes de liberté individuelle et de vie privée ». La réglementation des algorithmes et de l’intelligence artificielle ne peut donc être universelle.

Cependant nous vivons actuellement dans un système mondialisé où il n’existe pas de barrière étanche à la diffusion des programmes informatiques. Le rapport rendu par le CCNE et la CERNA sur « Numérique et santé » suggère ainsi de ne pas imposer en France une législation trop rigide qui freinerait la recherche française. Cela risquerait en effet de pousser les industries du secteur de la santé vers des solutions numériques développées par d’autres pays, avec des critères de sécurité et d’éthique encore moins contrôlés.

Biais, jugements de valeur et discriminations

Alors que certains imaginent les algorithmes comme des outils objectifs et infaillibles, Christine Balagué, également membre de la CERNA et de l’Institut DATAIA souligne leurs faiblesses : « la pertinence des résultats d’un algorithme dépend des informations qui lui sont fournies pour son apprentissage, de la manière dont il fonctionne, des paramètres configurés. » Or des biais peuvent avoir été introduits aux différentes étapes.

Tout d’abord au niveau des données d’apprentissage : il peut y avoir un problème de représentativité, comme pour les études pharmacologiques, généralement réalisées sur des hommes caucasiens de 20 à 40 ans. Les résultats établissent sur cette population l’efficacité et la tolérance du médicament testé, mais ne sont pas forcément extrapolables aux femmes, aux personnes âgées… Il peut également y avoir un problème de qualité des données : la précision et la fiabilité ne sont pas forcément homogènes selon leur source.

Le traitement des données, le code à proprement parler, contient également des éléments qui ne sont pas « neutres », et peuvent reproduire des jugements de valeurs ou des discriminations portés par leurs concepteurs. « Il n’y a pas forcément de mauvaises intentions chez les développeurs, mais ils ne reçoivent aucune formation à ces problématiques, et ils n’imaginent pas les implications de certains choix qu’ils font dans l’écriture des programmes » explique Grazia Cecere, chercheuse en économie au sein de l’Institut Mines-Télécom business school.

À lire sur I’MTech : L’éthique, grande oubliée des algorithmes ?

Dans le domaine de l’imagerie médicale par exemple, la détermination d’une zone peut être litigieuse. Un médecin aura tendance à vouloir classer les images douteuses en « positives » pour ne pas passer à côté d’une éventuelle anomalie qui pourrait être un cancer, et augmentera donc le nombre de faux-positifs. A l’inverse, un chercheur aura tendance pour maximiser la pertinence de son outil à favoriser les faux-négatifs. Leurs objectifs ne seront pas les mêmes, et le traitement des données reflétera ce jugement de valeur.

Sécurité, loyauté, opacité

La sécurité des bases de données médicales est très débattue, avec le risque d’une ré-identification par des algorithmes des informations anonymisées, et leur utilisation à des fins malveillantes ou discriminatoires (par les employeurs, les compagnies d’assurance…). Mais la sécurité des données de santé passe aussi par une sensibilisation individuelle. « Les gens ne réalisent pas forcément qu’ils dévoilent des informations critiques dans leurs publications sur les réseaux sociaux, ou par leurs recherches Google, comme une maladie, un problème de surpoids… » relève Grazia Cecere.

Les applications labellisées « santé » sont souvent intrusives, et collectent des données qui pourront être vendues à des tiers potentiellement malveillants. Mais les éléments recueillis seront également responsables d’une catégorisation de la part des algorithmes de Google ou de Facebook. En effet, ces sociétés n’ont pas pour vocation première de fournir une information objective et représentative, mais d’être rentables. Or, pour garder une audience, il vaut mieux lui montrer ce qu’elle a envie de voir.

Cette problématique est celle de la loyauté des algorithmes, réclamée fin 2016 en France par la loi pour une république numérique. « Diverses études ont montré qu’il y a une discrimination dans le type de résultats ou de contenus présentés par les algorithmes, avec un effet d’enfermement dans un cercle social ou un courant de pensée. Les antivax par exemple verront beaucoup plus de publications allant dans leur sens » détaille Grazia Cecere. Ces mécanismes sont problématiques, car ils constituent un frein à la diffusion des messages de prévention et de santé publique, les populations les plus à risques y étant les moins exposées.

L’opacité des algorithmes utilisant le deep learning est également un sujet de débat et de réglementation. « Des chercheurs ont créé un modèle de diffusion de virus comme Ebola en Afrique. Il semble être efficace. Mais peut-on pour autant désactiver les réseaux de surveillance pilotés par l’OMS, composés d’épidémiologistes et de professionnels de santé sur le terrain, qui coûtent très cher, alors que personne n’est capable d’expliquer les prédictions du modèle ? » s’interroge Christine Balagué.

Des chercheurs venant à la fois des sciences dures et des sciences humaines et sociales réfléchissent à la manière de rendre ces technologies responsables. L’objectif est de pouvoir intégrer directement un programme vérifiant que l’algorithme n’est pas corrompu et va respecter les principes de la bioéthique. Une technologie « responsible by design » en quelque sorte, qui rappelle un peu les trois lois de la robotique d’Asimov.

Article rédigé par Sarah Balfagon, pour I’MTech.

Trackbacks (rétroliens) & Pingbacks

[…] des données sensibles, sur la personne, mais également sur son environnement. Pour respecter les normes de sécurité européennes en matière d’e-santé, il a été nécessaire de mettre en place les mécanismes de sécurité adéquats. Le système […]

[…] Algorithmes éthiques en santé : un défi technologique et sociétal […]

[…] Algorithmes éthiques en santé : un défi technologique et sociétal […]

[…] des données sensibles, sur la personne, mais également sur son environnement. Pour respecter les normes de sécurité européennes en matière d’e-santé, il a été nécessaire de mettre en place les mécanismes de sécurité adéquats. Le système […]

[…] Algorithmes éthiques en santé : un défi technologique et sociétal […]

[…] Algorithmes éthiques en santé : un défi technologique et sociétal […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !