Nos expressions passées au crible algorithmique

Chercheur à IMT Lille Douai, Mohamed Daoudi s’intéresse à la reconnaissance des expressions faciales dans les vidéos. Ses travaux sont fondés sur l’analyse géométrique du visage et des algorithmes de machine learning. Ils pourraient ouvrir la porte à des applications dans le domaine médical.

Colère, tristesse, joie, surprise, peur, dégoût. Six émotions qui se traduisent chez l’humain par des expressions faciales universelles, quelle que soit sa culture. Une constante prouvée par les travaux du psychologue Paul Ekman publiés dans les années 1960 et 1970. Presque 50 ans plus tard, les scientifiques utilisent ces résultats pour automatiser la reconnaissance d’expressions faciales à partir de vidéos par des algorithmes d’analyse de forme. C’est le cas de Mohamed Daoudi, chercheur à IMT Lille Douai en vision par ordinateur.

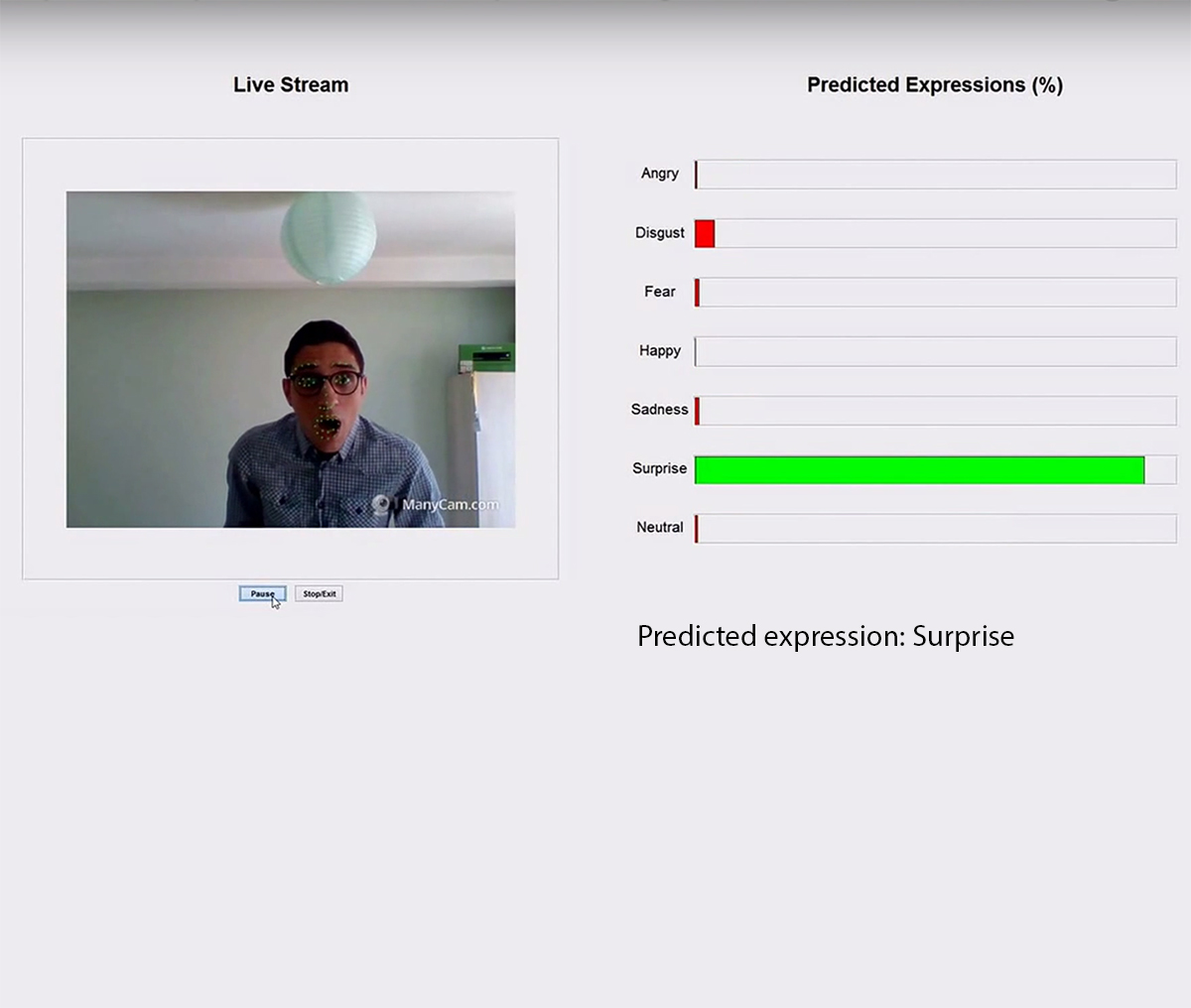

« Nous développons des outils informatiques qui permettent de placer des points caractéristiques sur l’image d’un visage : aux commissures des lèvres, autour des yeux, du nez… » détaille Mohamed Daoudi. Cette opération est effectuée d’une manière automatique pour chaque image d’une vidéo. Une fois cette étape terminée, le chercheur dispose d’une modélisation dynamique du visage sous forme de points qui évoluent dans le temps. Ce sont les mouvements de ces points, ainsi que leur position relative, qui donnent des indications sur les expressions faciales. Comme chacune est caractéristique, la façon dont les points évoluent dans le temps est significative d’une expression.

Les modélisations par points des visages sont ensuite traitées par des outils de machine learning. « Nous entraînons nos algorithmes sur des bases de données qui leur permettent d’apprendre la dynamique de points caractéristiques de la joie ou de la peur » explique Mohamed Daoudi. En comparant les nouvelles mesures de visages avec cette base de données, l’algorithme est capable de classer une nouvelle analyse vidéo d’une expression dans une des six catégories.

Ce genre de travaux intéresse plusieurs secteurs industriels. C’est le cas de l’observation de la satisfaction client pour l’achat d’un produit. Le projet FUI Magnum s’intéresse à cette application. En observant le visage d’un client, il pourrait être possible de détecter si son expérience a été agréable ou non. Dans ce cas, il ne s’agit pas forcément de détecter une expression précise, mais plutôt de qualifier son état comme positif ou négatif, et dans quelle mesure. « C’est parfois amplement suffisant, nous n’avons pas besoin de déterminer si la personne est triste ou joyeuse pour ce type de situation » souligne Mohamed Daoudi.

Le chercheur d’IMT Lille Douai met en avant les avantages d’une telle technologie dans le milieu médical par exemple : « En psychiatrie, les praticiens regardent beaucoup les expressions pour obtenir des indications sur l’état psychologique d’un patient en particulier la dépression. » En assistant cette analyse d’expressions faciales par une caméra et un ordinateur voire un smartphone, le psychiatre peut évaluer d’une manière plus objective le traitement administré au patient. Étudier rigoureusement l’évolution de leur visage peut permettre de détecter la douleur chez certains patients qui ont du mal à l’exprimer. C’est notamment le but d’un travail mené par le doctorant Taleb Alashkar, dont la thèse est financée par le programme Futur & ruptures de l’IMT et encadrée par Mohamed Daoudi et Boulbaba Ben Amor. « Nous avons proposé un algorithme capable de détecter la douleur à partir de séquences de visage 3D » assure Mohamed Daoudi.

Le chercheur se garde bien par ailleurs de présenter ses recherches comme de l’analyse émotionnelle. « Nous faisons de la reconnaissance d’expressions faciales. L’émotion est un degré au-dessus. » fait-il remarquer Car si une expression relative à la joie peut être détectée, cela ne permet pas d’en déduire pour autant que la personne est heureuse. Il faudrait pour cela que les algorithmes puissent certifier avec assurance que l’expression n’est pas feinte. Or cela, Mohamed Daoudi assure que ce sont des travaux toujours en cours. Mais l’objectif est bien d’injecter de l’émotion dans nos machines qui vont devenir de plus en plus intelligentes.

[divider style= »normal » top= »20″ bottom= »20″]

![]()

De la 3D à la 2D

Pour améliorer la reconnaissance faciale sur les vidéos en 2D, les chercheurs intègrent leurs algorithmes de détection de forme et de mouvement utilisés pour la 3D. Ainsi, afin d’étudier plus facilement les visages sur les vidéos 2D, Mohamed Daoudi capitalise sur les résultats du projet ANR 3D Face Analyser, mené avec Centrale Lyon et des universitaires en Chine. Parfois les déformations sont tellement petites qu’elles sont difficiles à classer. Il faut donc créer des outils numériques qui permettent de les amplifier. Avec des collègues de l’université de Beihang, l’équipe de Mohamed Daoudi a réussi à amplifier les déformations géométriques subtiles du visage pour mieux les classer.

[divider style= »normal » top= »20″ bottom= »20″]

Trackbacks (rétroliens) & Pingbacks

[…] Nos expressions passées au crible algorithmique […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !