Quèsaco l’edge computing ?

L’edge computing est un paradigme informatique qui consiste à traiter des données à la périphérie du réseau, grâce à des ressources locales et à moindre échelle. L’edge computing permet essentiellement de réduire les temps de communication en évitant le transfert de données vers le cloud, dont les centres de traitement sont éloignés. Georgios Bouloukakis, chercheur à Télécom SudParis, nous en dit plus sur ses avantages, et ses inconvénients. Il nous parle également du futur de cette approche de calcul, quoiqu’encore très expérimentale, entre solutions fractionnées ou Computing Continuum.

Dans quel contexte a émergé l’edge computing ?

Georgios Bouloukakis : L’edge computing (traduisible en informatique par « périphérie de réseau ») est un ensemble de technologies ou domaine de recherche qui a gagné en popularité ces dernières années avec la montée en puissance du cloud computing. Le cloud computing, qui permet de louer des ressources ou encore de déployer des logiciels et des applications à distance, a ouvert de nombreuses possibilités en termes de business.

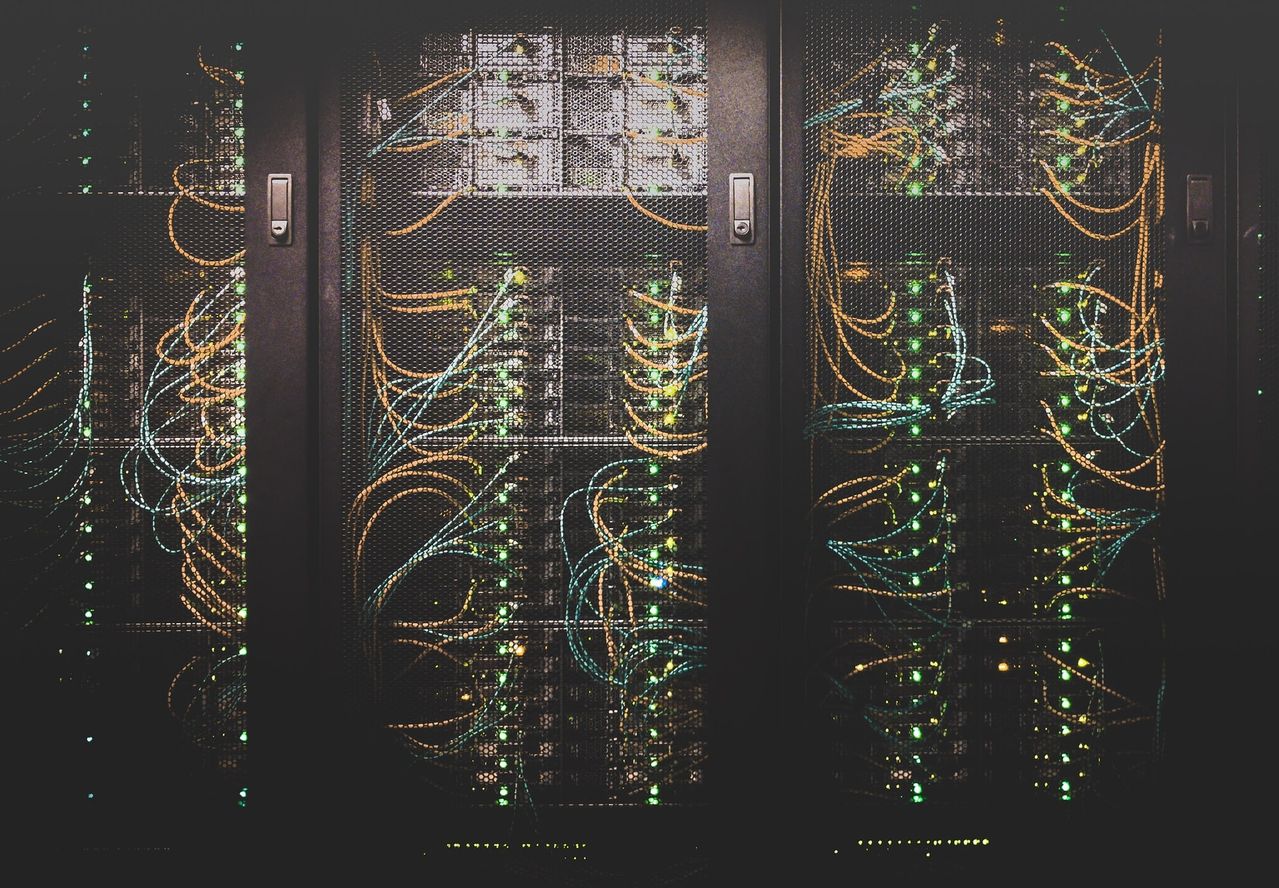

Le problème lorsque vous avez des ressources sur le cloud – par exemple une application mobile – c’est que les données sont envoyées à des serveurs hébergés dans des centres de données (data centers) parfois très lointains : en Allemagne, aux États-Unis, n’importe où ! Une des idées de l’edge computing est de rapprocher ces ressources de calcul et de stockage afin d’éviter que les données ne voyagent dans d’autres pays, où les réglementations en matière de protection de la vie privée sont différentes.

L’edge computing fait aussi écho à l’accélération des technologies de l’intelligence artificielle (IA). Pour entraîner des algorithmes et faire de l’analyse de données, il y a un intérêt à ce que le traitement soit plus proche, pour réduire la latence, distribuer les ressources, ou garder les données à proximité, dans un campus universitaire par exemple.

Quels sont les avantages de l’edge-computing ?

GB : Le principal avantage est de réduire la latence, qui passe de quelques millisecondes à quelques nanosecondes. Pour rester sur l’IA, une quantité massive de données est traitée pour aider des algorithmes à prendre des décisions en temps réel. L’envoi de toutes ces données sur le cloud et leur retour pour la prise de décision va prendre un certain temps, mais si elles sont envoyées vers un serveur périphérique, proche du réseau local, la décision peut être obtenue en un temps réduit. Ce gain de temps est crucial dans certains cas d’usage, comme dans les établissements de soins pour personnes âgées, où la rapidité de traitement de données peut conduire à des décisions salutaires.

L’utilisation de ressources en périphérie présente aussi des avantages énergétiques. Les services de cloud computing reposent sur des centres de données qui consomment beaucoup d’énergie et nécessitent d’être refroidis par des systèmes de ventilation également très énergivores. En se déplaçant à la périphérie, il est possible d’imaginer des solutions avec un impact réduit sur l’environnement, voire bénéfiques pour les utilisateurs finaux. Certaines entreprises ont par exemple envisagé de réemployer la chaleur produite par des centres de données locaux pour chauffer des maisons ou des centres communautaires. C’est le cas des entreprises jumelles Qarnot/Qalway.

Quels acteurs trouve-t-on derrière ce service ?

GB : Les grands acteurs du numérique ont évidemment essayé de s’emparer du sujet : Microsoft a créé des plateformes pour déployer des applications Internet-of-Things (IoT) sur des ressources périphériques. Ces prestataires offrent également la possibilité de sélectionner des serveurs de proximité, dans des régions spécifiques. Cependant pour être légitimes, ils devraient disposer de centres de données partout, ce qui n’est pas le cas.

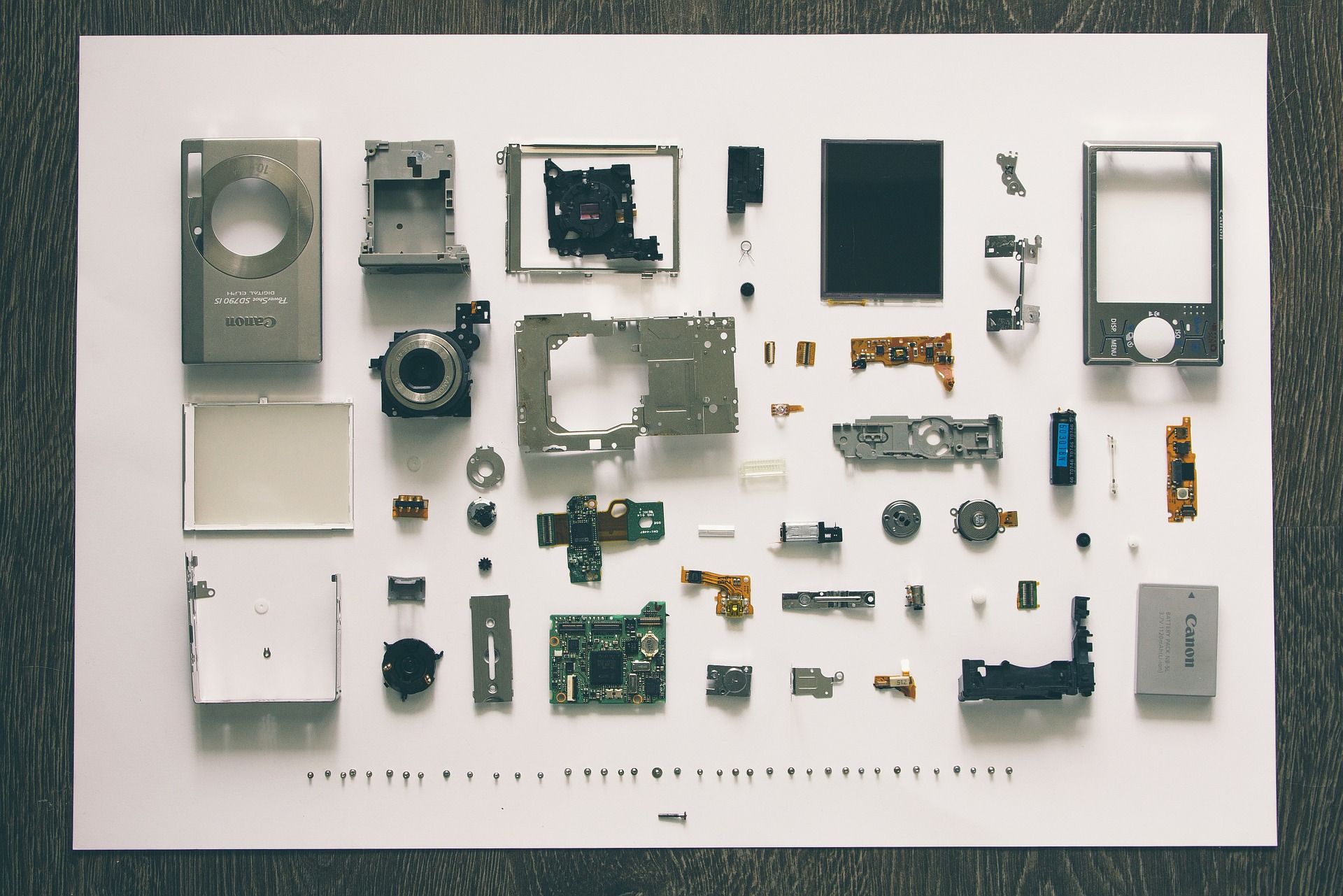

Or le concept de l’edge-computing est que les ressources soient vraiment proches, à l’échelle d’une ville, d’un quartier, voire même d’une maison. En outre, les ressources, très diverses, n’ont pas besoin d’être constamment connectées au réseau ; il peut s’agir d’ordinateurs portables, de smartphones, de capteurs… Ces ressources hétérogènes sont coordonnées par des orchestrateurs (parmi lesquels on peut citer la solution Kubernetes de Google). On trouve également des logiciels d’infrastructure, des CaaS (Computing as a service), des AIaaS (AI as a service)… C’est un écosystème complexe dans lequel évolue beaucoup de monde : on est loin d’un modèle commercial, mais encore sur un outil de recherche. C’est pourquoi, les universités sont particulièrement enclines à pousser cette technologie, en hébergeant en laboratoire notamment des ordinateurs monocartes, qui équivalent à des centres de données de petite taille.

Pourquoi ne pas envisager de passer tous les services en edge-computing plutôt que sur le cloud ?

GB : En réalité, il y a un arbitrage permanent à faire entre le cloud et l’edge computing. Nous avons soulevé le sujet des données qui voyagent avec le cloud mais il faut admettre que ces plateformes, développées par des acteurs majeurs tels que Google, Amazon ou Cisco, offrent une sécurité accrue. Il est beaucoup plus sûr d’avoir ses données dans des data centers qui disposent de pare-feu robustes, que quelque part à la périphérie, sur un ordinateur potentiellement vulnérable aux attaques.

Sur la question énergétique, le cloud dispose généralement des ressources suffisantes pour exécuter un algorithme d’IA très gourmand avec une moindre consommation d’énergie et une moindre production de chaleur. En revanche, si vous essayez d’exécuter le même algorithme à la périphérie, par exemple depuis un ordinateur monocarte, celui-ci est plus contraint en ressources et va générer une consommation d’énergie et une surchauffe plus importante. Chaque cas est différent et demande d’évaluer la solution la plus intéressante.

Quelles sont les évolutions envisagées pour améliorer ce service ?

GB : Pour répondre au problème de l’efficacité énergétique en périphérie, la recherche se tourne vers le « Split-computing », le fractionnement de calcul. Cette solution consiste à répartir la ressource informatique requise pour une tâche, notamment pour les algorithmes d’IA, entre plusieurs ressources périphériques. La piste est prometteuse, mais pour le moment il n’est pas possible de savoir vers quelles ressources périphériques le calcul sera redirigé, donc elle s’accompagne aussi d’une réflexion sur comment choisir la meilleure ressource pour exécuter la tâche.

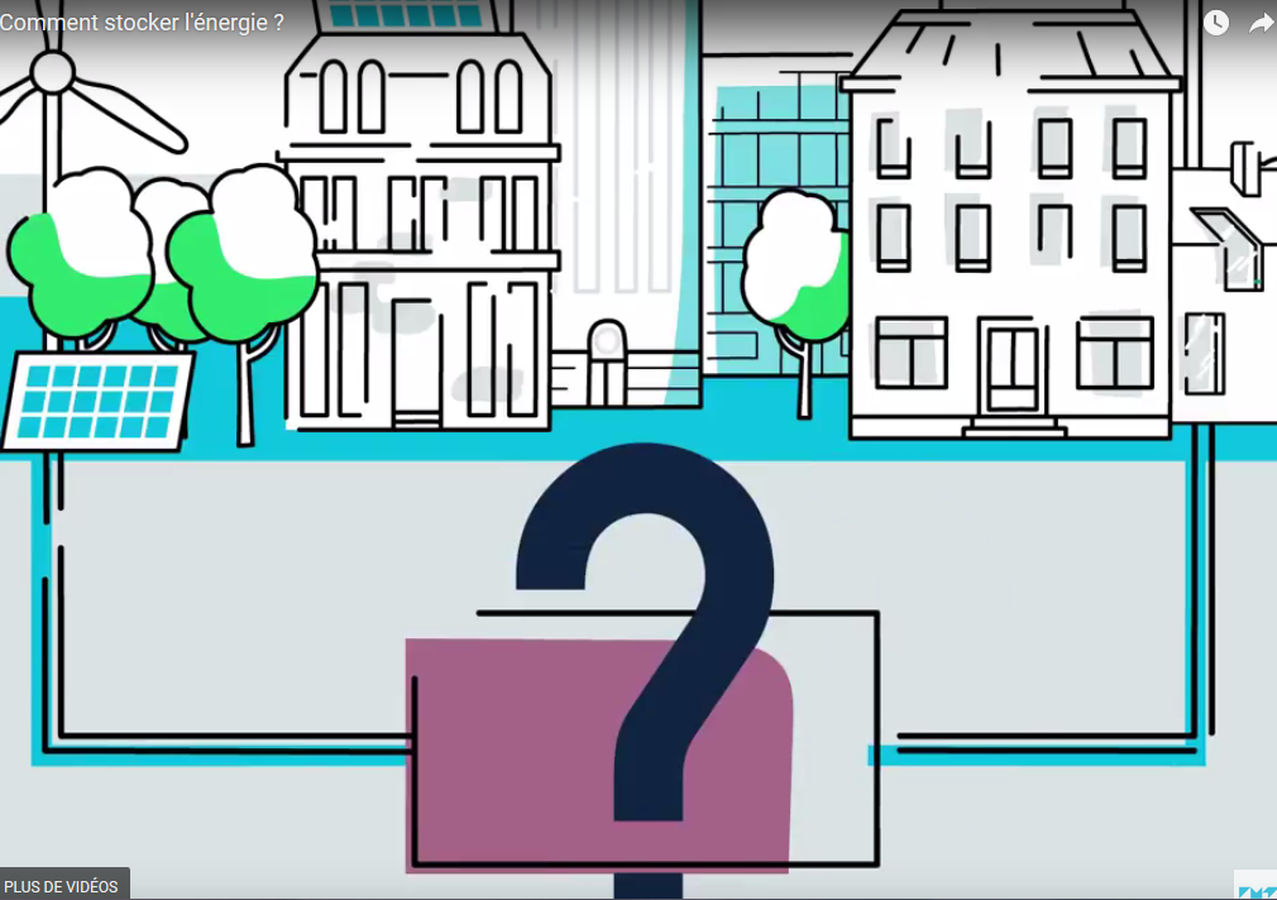

Cela dit, la communauté de recherche s’oriente de plus en plus vers un autre paradigme : le « Computing Continuum » (littéralement « continuum informatique ») ou continuum IoT-Edge-Cloud. En créant un ensemble de ressources, composée à la fois des IoT, des micro-ordinateurs et du cloud à plus grande échelle, il ne sera plus nécessaire d’arbitrer entre les différentes technologies. Vous pouvez dès lors développer une solution optimale faisant appel à toutes les ressources du continuum.

Imaginez par exemple, dans une ville équipée de caméras, que vous souhaitiez surveiller les infractions au stationnement, et contrôler les incendies structurels dans les bâtiments. Les mêmes caméras sont utilisées pour détecter ces deux paramètres. L’utilisation du cloud est appropriée dans le cas des infractions car la latence n’est pas un problème : les vidéos peuvent être envoyées vers le cloud puis transmises à la police ou au propriétaire. Mais dans le cas d’un incendie, l’information doit transiter le plus rapidement possible afin d’alerter les pompiers. Il est donc préférable d’utiliser des ressources proches de la caméra, comme un serveur périphérique dans la ville, voire même de faire la détection sur la caméra !

Bien sûr, l’utilisation du Computing Continuum requiert le développement de solutions logicielles intermédiaires pour qu’un message relatif à un stationnement soit envoyé sur le cloud et qu’un message relatif à un incendie soit traité en IoT. Mais l’Union européenne y croit, et de nombreux appels ont été lancés pour déployer des solutions intelligentes sur la base du continuum.

Propos recueillis par Ingrid Colleau.

Trackbacks (rétroliens) & Pingbacks

[…] bien sûr emparée avec force de ce sujet. Dans ce contexte, l’apprentissage distribué, l’edge computing et la compression des réseaux neuronaux deviennent des sujets méthodologiques majeurs, sur […]

[…] L’edge computing correspond à la gestion des données en périphérie de réseau. Il permet de rapprocher les utilisateurs-clients des fournisseurs de service cloud stockant les données, par l’installation de serveurs de proximité installés localement auprès des utilisateurs finaux. Cela réduit du même coup les difficultés de latence et le contrôle des données stockées dans les data centers des hyperscalers (les géants du cloud comme Amazon, Google Microsoft). Cette proximité avec les utilisateurs finaux est l’un des fondements du cloud de confiance. […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !