Intelligence artificielle : normes techniques et droits fondamentaux, un mélange risqué

Article rédigé par Mélanie Gornet et Winston Maxwell, Télécom Paris. Cet article a été publié en partenariat avec le média The Conversation France.

Le futur règlement européen « AI Act » a pour but la création d’un cadre légal pour l’ensemble des systèmes d’intelligence artificielle (IA), notamment ceux posant des risques importants pour la sûreté ou les droits fondamentaux, comme la non-discrimination, la vie privée, la liberté d’expression ou la dignité humaine.

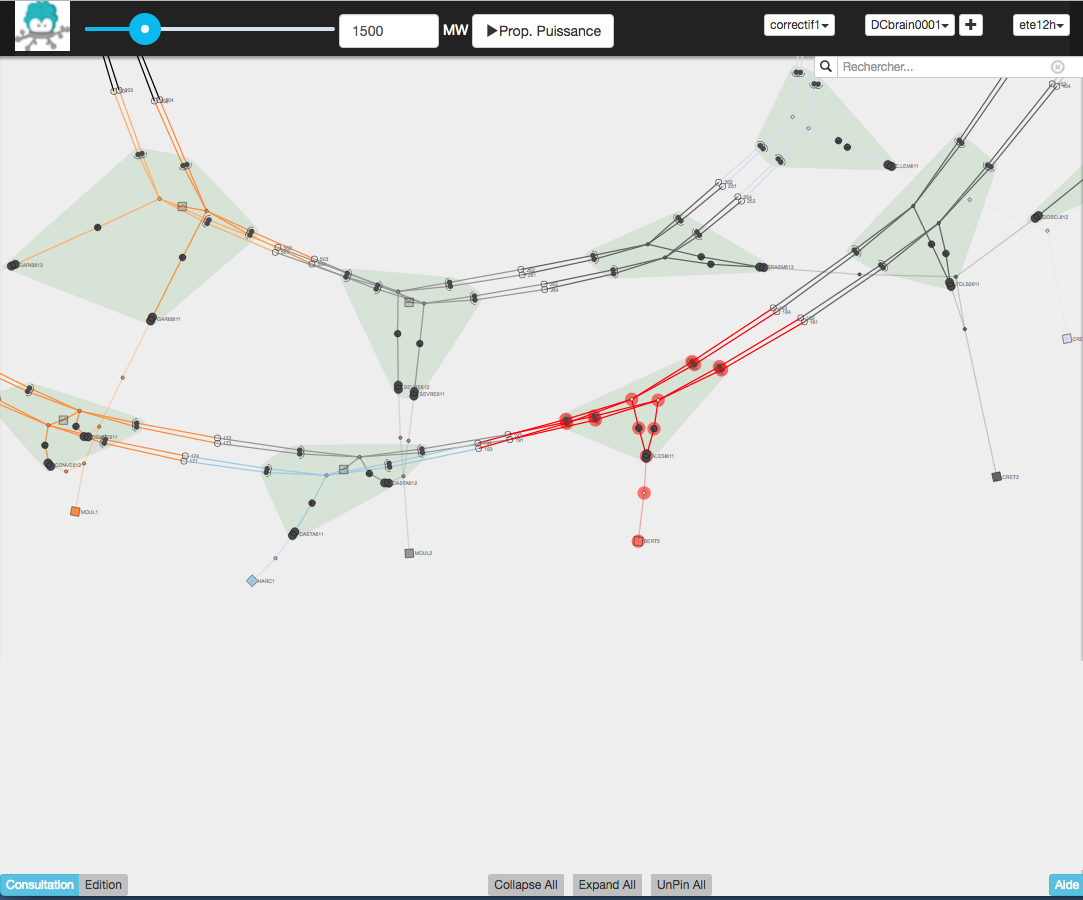

Dans sa version actuelle, le projet de règlement traite tous ces risques de la même manière. Un marquage CE (pour « conformité européenne », comme celui existant), indiquerait que le système d’IA est jugé suffisamment sûr pour être mis sur le marché, qu’il s’agisse de la sûreté physique ou vis-à-vis des droits fondamentaux. Le texte présenté accorde une grande importance aux normes techniques et aux analyses de risques, espérant pouvoir standardiser les méthodes d’évaluation.

Néanmoins, il persiste une tension entre l’approche « par les risques », proposée par la Commission, et l’approche axée sur le respect des droits fondamentaux, privilégiée par les tribunaux et par les travaux du Conseil de l’Europe.

En effet, s’il est facile d’imaginer un banc de tests pour un critère de sûreté, à la manière des essais réalisés sur les jouets pour enfants avant leur mise sur le marché, il est plus difficile d’évaluer la non-discrimination de cette façon, car elle est contextuelle.

Tester la discrimination : pari impossible ?

Pour qu’un produit puisse être mis sur le marché, les fournisseurs devront respecter certaines spécifications techniques définies en dehors du texte de loi, le plus souvent dans des normes harmonisées.

De nombreux pays fondent de grands espoirs sur ces normes, qui pourraient contribuer à établir des exigences techniques et juridiques uniformes pour les systèmes d’IA. Par exemple, elles pourront définir les critères de qualité, d’équité, de sécurité ou encore d’explicabilité pour ces systèmes, et même renforcer le positionnement stratégique de l’Europe dans la course mondiale pour l’IA.

Mais comment développer des critères techniques neutres autour de jugements de valeur moraux et culturels ?

Certains de ces systèmes impactent directement notre droit à la non-discrimination. Par exemple, l’utilisation de la reconnaissance faciale par les services de police a amené à l’arrestation de plusieurs hommes noirs, reconnus à tort par un système automatique sur des caméras de vidéosurveillance. De la même manière, l’algorithme de recrutement d’Amazon refusait plus facilement un CV de femme que celui d’un homme.

Pour tester la présence de ce type de biais discriminants, les techniques actuelles consistent à vérifier le bon fonctionnement du système pour différents sous-groupes de la population, séparant les individus par genre ou couleur de peau. Mais standardiser ces méthodes de test soulève plusieurs difficultés.

Tout d’abord, la législation de certains pays interdit le traitement de données ethniques. Ensuite, choisir sur quels groupes tester est un choix politique : qui décidera du nombre de catégories de « couleurs de peau » à tester ? Finalement, un tel système ne pourra jamais être parfaitement équitable, car il existe de nombreuses approches de la non-discrimination, dont certaines sont incompatibles entre elles.

Un niveau « acceptable » de risque de discrimination ?

Puisqu’il sera impossible de garantir l’absence de discrimination sous tous les angles, des choix seront nécessaires, et des seuils de tolérance devront être définis. Se pose alors la question : quel est le niveau acceptable d’erreurs et de quel type d’erreurs parle-t-on ? Ce qui revient à se demander : quel est le niveau « acceptable » de risque de discrimination ?

Dans d’autres domaines, il est courant de définir le niveau acceptable de risque par une démarche quantitative. Par exemple, pour la sûreté d’une centrale nucléaire, le risque d’un accident sera quantifié, et la centrale pourra ouvrir si le risque est en deçà d’un certain seuil d’acceptabilité. Ce seuil ne pourra pas être de zéro, car une approche « zéro risque » conduirait au rejet de l’activité nucléaire qui procure par ailleurs des bénéfices pour la société. Les bénéfices de l’énergie nucléaire et les risques sont pesés, et il est décidé en pratique d’un seuil « acceptable » de risque. Bien que ce seuil puisse être discuté, il est étayé par des faits scientifiques : les risques sont relativement faciles à définir et à mesurer.

Qu’en est-il pour les systèmes d’IA ? Si on reprend la question des discriminations – raciales ou de genre par exemple, une norme technique ne pourrait jamais nous dire quel est le « bon » taux d’erreur, ou un niveau « acceptable » de différences de performance entre différents groupes de la population, car la réponse est trop dépendante du contexte et du jugement des personnes.

L’objectif des normes techniques dans le cadre de l’IA devrait plutôt être de définir un vocabulaire commun, des tests adaptés, des études d’impacts et plus généralement des bonnes pratiques tout au long du cycle de vie des systèmes d’IA. Cela permettrait d’obtenir une base de comparaison des systèmes et de favoriser la discussion entre les parties prenantes. Ce type de normes est appelé « normes d’information », par opposition aux « normes de qualité » ou de « performance ».

Par exemple, pour un système de reconnaissance faciale pour le passage aux frontières, une norme technique pourrait décrire comment mesurer la précision du système et comment mesurer les différences de performance entre différents groupes de la population. Cette norme ne définirait pas quel niveau d’erreur et de discrimination est acceptable, ni quels groupes doivent être protégés, car ces choix relèvent de l’application du droit et de l’appréciation des tribunaux.

Qui doit décider des normes ?

Les organismes de normalisation travaillent actuellement sur ces standards pour l’IA, avec une attention particulière pour l’éthique. On notera notamment les initiatives de l’association IEEE, les premiers à publier un standard « pour la prise en compte des préoccupations éthiques lors de la conception de systèmes », ainsi que divers autres standards sur la transparence, ou encore la confidentialité des données.

Des normes ISO sont également en cours de rédaction grâce à différents groupes de travail organisés autour de cette thématique commune de l’IA, et regroupant des organismes de différents pays, comme l’AFNOR en France. Ce travail est coordonné au niveau européen par la CEN-CENELEC et sa « feuille de route sur l’IA ». Aux États-Unis, le National Institute of Standards and Technology (NIST) est chargé de comparer les performances et l’équité des systèmes de reconnaissance faciale et a publié récemment des lignes directrices pour éviter les biais dans les systèmes d’apprentissage.

Or ces délibérations sur des questions pourtant fondamentales se passent bien souvent derrière des portes closes. Seuls les organismes habilités peuvent développer ces standards et bien qu’ils fassent souvent appel à des participations extérieures, l’accessibilité des travaux est limitée. Le système actuel contraint une entreprise à payer pour avoir accès au texte de la norme, réduisant la transparence du processus. Comment garantir alors que les spécifications techniques préservent effectivement nos droits ? Ne faudrait-il pas plutôt proscrire le développement de ces normes opaques au profit d’une procédure plus ouverte au débat citoyen ?

La certification, un outil à double tranchant

Ces normes peuvent également se révéler inutiles, voire dangereuses si elles sont mal utilisées, par exemple si elles servent à l’apposition d’une certification prétextant prémunir de toute violation de nos libertés. En effet, l’apposition d’un marquage CE n’indique que la conformité avec les règles du moment, déclarée par le fabricant, mais ne garantit pas la sûreté ou l’absence formelle de discrimination.

Ce problème est aggravé par la « présomption de conformité » créée par la certification : lorsqu’un système suit une norme, sa sûreté est moins souvent remise en question. Il est alors primordial de construire un marquage CE qui ne déleste pas les fournisseurs et utilisateurs des systèmes d’IA de leur responsabilité. Le marquage servirait alors non pas à garantir qu’un système est exempt d’atteinte aux droits fondamentaux, mais à garantir que l’entreprise a mis en place des mesures pour les limiter.

Le marquage CE peut être un formidable outil de régulation et de gouvernance une fois couplé à des normes techniques nous aidant à parler le même langage et à comparer les systèmes entre eux. En revanche, la décision de ce qu’est un risque « acceptable » pour les droits humains ne peut jamais être déléguée à une norme technique. Il convient de réaffirmer la responsabilité des fournisseurs et utilisateurs de ces systèmes qui doivent eux-mêmes définir, dans leur contexte, le choix le plus approprié pour protéger les droits fondamentaux. Cette décision devra être justifiée et pourra être contestée, mais l’arbitrage final de l’acceptabilité du risque devra être laissé au législateur, au régulateur et aux juges.

Mélanie Gornet, Doctorante en droit et éthique de l’IA, Télécom Paris – Institut Mines-Télécom et Winston Maxwell, Directeur d’Etudes, droit et numérique, Télécom Paris – Institut Mines-Télécom

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !