Informatisation des écritures, une perte de caractère ?

Avec l’usage d’Internet et des nouvelles technologies, nous nous appuyons essentiellement sur la modalité écrite pour communiquer. Un bouleversement qui relance l’intérêt pour la graphématique, branche de la linguistique concentrée sur l’étude de l’écriture. Yannis Haralambous, chercheur à IMT Atlantique en traitement automatique du langage et fouille de textes a participé à l’organisation du colloque /gʁafematik/ les 14 et 15 juin derniers. Un point sur les recherches actuellement menées en graphématique, mais également l’occasion de soulever des interrogations quant à l’avenir des écritures informatisées dans le codage Unicode, détenteur du devenir des langues et de leurs caractères…

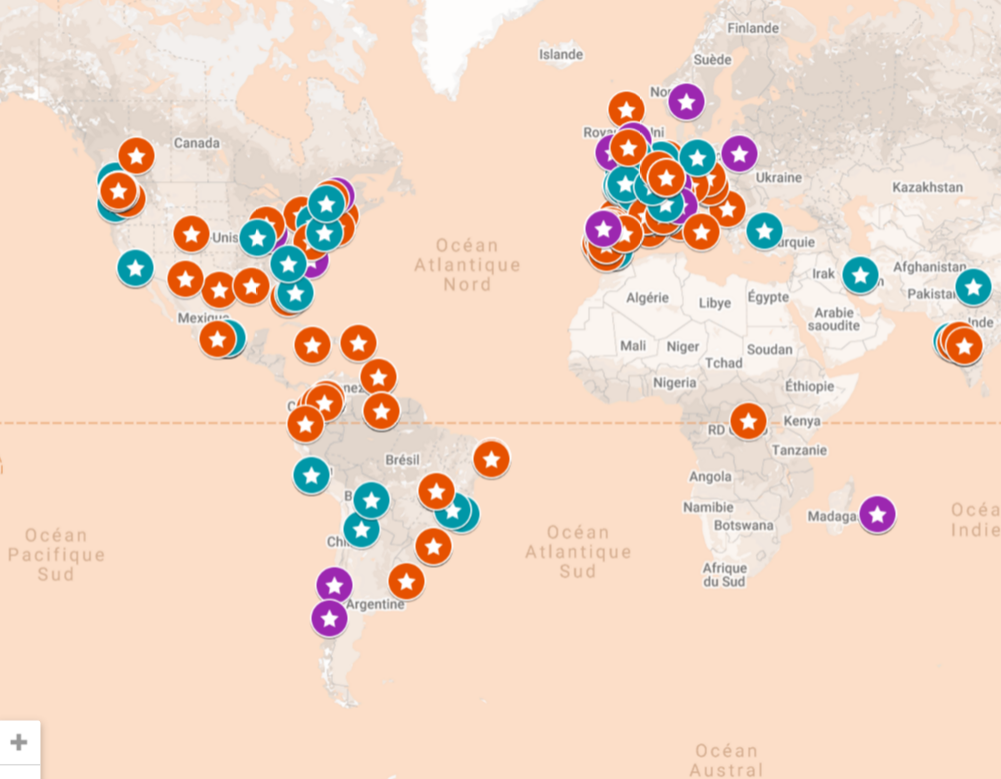

Graphématique. Vous n’avez jamais entendu ce mot ? Rien d’anormal ! Désignant une branche de la linguistique analogue à la phonologie mais concernée par la modalité écrite de la langue, cette discipline a longtemps été mise à l’écart, la linguistique se concentrant plus volontiers sur l’oral que sur l’écrit. C’est sans compter avec l’avènement des nouvelles technologies, basées sur une modalité textuelle forte, qui vient changer la donne. D’où le regain d’intérêt croissant pour l’étude de l’écrit. « La graphématique intéresse aussi bien les linguistes que les informaticiens, les psychologues, les chercheurs en sciences de la communication et les typographes » constate Yannis Haralambous, chercheur à IMT Atlantique en traitement informatique du langage et fouille de textes. « J’ai voulu réunir toutes ces disciplines en organisant le colloque /gʁafematik/ les 14 et 15 juin 2018, sur le thème de la graphématique au xxie siècle. »

Entre autres, des typographes sont venus y parler de la lisibilité des caractères typographiques sur écran. En se basant sur des études psycholinguistiques de terrain, ils travaillent à la conception de polices de caractère spécifiques pour les enfants ou pour les personnes ayant des difficultés à lire. D’autre part, plusieurs recherches ont été présentées sur l’utilisation des emoji. Celles-ci montrent comment ces petits pictogrammes à peine plus gros que des lettres peuvent enrichir le texte par leur empreinte émotionnelle ou remplacer des mots voire des phrases entières, changeant la face de notre langage écrit sur les réseaux sociaux. Aussi, la vitesse et la façon dont nous tapons un texte sur notre clavier pourraient être des signatures d’identification biométrique, avec de possibles applications en cybersécurité ou pour le diagnostic de pathologies comme la dyslexie.

Mais parmi toutes les recherches présentées à ce colloque, un acteur phare de notre langage écrit a retenu l’attention de tous : Unicode. Quiconque saisit du texte par ordinateur a constamment affaire, sans réellement s’en rendre compte, à ce codage de caractère généraliste et universel. Mais sa volonté d’intégrer toutes les langues du monde n’est pas sans conséquence sur l’évolution des systèmes d’écriture et plus particulièrement ceux des langues vivantes «peu dotées» ou des langues mortes.

Un codage hégémonique à remettre en question

Tapez sur une touche de votre clavier, par exemple celle correspondant à la lettre «e». Un message est transmis à votre machine sous la forme d’un nombre, un code numérique, reçu par le pilote de clavier et converti immédiatement en une information numérique appelée caractère Unicode. C’est cette information qui est stockée ou transmise. En même temps, le pilote d’écran interprète ce caractère Unicode et affiche une image de la lettre «e» dans votre zone de traitement de texte. « Changez le clavier virtuel dans les préférences systèmes de votre machine pour écrire en russe ou en chinois, et la même touche sur le même clavier physique produira d’autres caractères issus d’autres systèmes d’écriture, proposés par Unicode » ajoute Yannis Haralambous.

Issu du travail d’un consortium d’acteurs de l’industrie informatique comme Microsoft, Apple ou IBM, Unicode est aujourd’hui l’unique système de codage de caractère à s’être imposé dans le monde entier. « Être le seul signifie avoir toute la responsabilité de l’évolution de l’écriture… » souligne le chercheur. En acceptant d’intégrer à son répertoire certains caractères et pas d’autres, Unicode a la mainmise sur l’informatisation des écritures. Si l’hégémonie d’Unicode ne pose pas de problème particulier pour une écriture fermée comme celle de la langue française, où le nombre de caractères ne varie pas, les systèmes d’écritures ouverts sont plus susceptibles d’être impactés. « Tous les ans, de nouveaux caractères sont inventés dans la langue chinoise par exemple, et le consortium d’Unicode doit suivre ! » poursuit le chercheur. Mais les plus fragiles restent les écritures mortes et anciennes. Une fois acceptées par le consortium d’Unicode, les propositions de codage amenées par des rapports de passionnés ou de spécialistes sont définitives. Les caractères enregistrés ne peuvent plus être modifiés ou supprimés. Incompréhensible pour Yannis Haralambous : « des erreurs s’accumulent et restent ad vitam aeternam ! »

Par ailleurs, si le clavier physique ne se prête pas naturellement à la transcription informatique de certaines langues riches de milliers de caractères différents comme le japonais ou le chinois, des méthodes de saisie phonétique et une suggestion de caractères associés par le système permettent de contourner la difficulté initiale. Mais certaines écritures indiennes, ou l’écriture arabe, souffrent clairement du principe même de découpage en caractères : « les mêmes glyphes peuvent être combinés de différentes manières en formant des ligatures qui changent le sens du texte » explique Yannis Haralambous. Mais Unicode n’est pas de cet avis : incompatibles avec son système de codage, ces ligatures sont considérées comme purement esthétiques, donc dispensables… Une perte pour le sens de certains écrits. Mais Unicode joue encore un rôle important sur un tout autre plan.

Vers une uniformisation des écritures ?

Si la langue orale s’apprend spontanément, la langue écrite s’enseigne. « En France, l’éducation nationale détient un certain pouvoir et participe à une institutionnalisation de l’écriture, tout comme les dictionnaires ou l’Académie française » constate Yannis Haralambous. Et, en plus des politiques langagières, c’est également Unicode qui impacte fortement l’évolution de l’écrit. « Unicode ne cherche pas à modifier ou à réguler, mais à implémenter. Cependant, par ses contraintes et ses choix techniques, le système exerce un pouvoir au même titre que les institutions. » Le chercheur dessine alors le trio qui donne, selon lui, une image complète de la situation des écritures et de leur évolution : l’étude linguistique de l’écriture, son institutionnalisation, et Unicode.

L’exemple de l’écriture malayalam, dans l’état indien du Kerala, montre bien l’importance du codage des caractères et du logiciel dans l’adoption d’un système d’écriture par une population. Dans les années 80, le gouvernement applique une réforme des ligatures de l’écriture malayalam pour la simplifier et ainsi faciliter son impression et son informatisation. Mais la population conserve son écriture manuscrite avec les ligatures complexes. Lors de l’arrivée d’Unicode en 1990, les systèmes d’exploitation Mac ou Windows intègrent la version simplifiée institutionnelle seulement. C’est sans compter avec le développement parallèle de logiciels libres, qui rendront disponible sur ordinateur l’écrit avec les ligatures traditionnelles. « Aujourd’hui, après une période de flottement au début des années 2000, l’écriture traditionnelle est revenue en force ! » constate le chercheur, tout en soulignant l’unicité de ce cas : « les réformes de l’écriture imposées par un gouvernement sont le plus souvent définitives, à moins d’un changement politique drastique. »

Écriture malayalam traditionnelle. Crédit : Navaneeth Krishnan S

Si dans le cas de l’écriture malayalam, le logiciel libre et l’écriture traditionnelle ont gagné, se dirige-t-on néanmoins vers une uniformisation de l’écriture dans ce processus d’informatisation des langues ? « Certains spécialistes prétendent que dans un siècle ou deux, nous parlerons tous un mélange de différentes langues avec une forte proportion d’anglais, mais également de chinois et d’arabe. Même chose pour l’écriture, avec une écriture latine qui finirait par s’imposer… Mais concrètement, nous n’en savons rien ! » répond Yannis Haralambous. Le chercheur souligne également que le passage à l’écriture latine est proposé au Japon et en Chine depuis des siècles sans succès. « Les schémas mentaux des locuteurs du chinois et du japonais sont construits sur les caractères : en abandonnant la structure des caractères, ils perdent la construction du sens… » Si notre langue participe ainsi à notre perception du monde, reste à identifier précisément le rôle de l’écriture dans ce processus. Une question de recherche complexe à résoudre. Comme le précise Yanis Haralambous « difficile de séparer la langue orale de la langue écrite pour comprendre laquelle influence le plus notre façon de penser… »

Trackbacks (rétroliens) & Pingbacks

[…] Informatisation des écriture, une perte de caractère ? […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !