La TV de demain : une expérience enrichie grâce aux écrans d’appoint ?

La télévision de demain s’invente dans les laboratoires d’Eurecom, à Sophia-Antipolis. Il ne s’agit pas de développer des technologies pour des écrans toujours plus grands ou plus nets, mais de réinventer les usages de la TV. Dans un projet du Fonds unique interministériel (FUI) baptisé NexGenTV, chercheurs, diffuseurs et développeurs s’associent pour atteindre ce but. Lancé en 2015 pour une durée de trois ans, il porte déjà ses fruits. Raphaël Troncy, chercheur à Eurecom en sciences de la donnée et engagé dans ce projet, nous présente les avancées déjà réalisées et des pistes d’amélioration, pour la plupart basées sur l’enrichissement de contenu grâce à un écran d’appoint.

Avec le projet NexGenTV, vous souhaitez revisiter les usages de la TV. D’où vient cette volonté ?

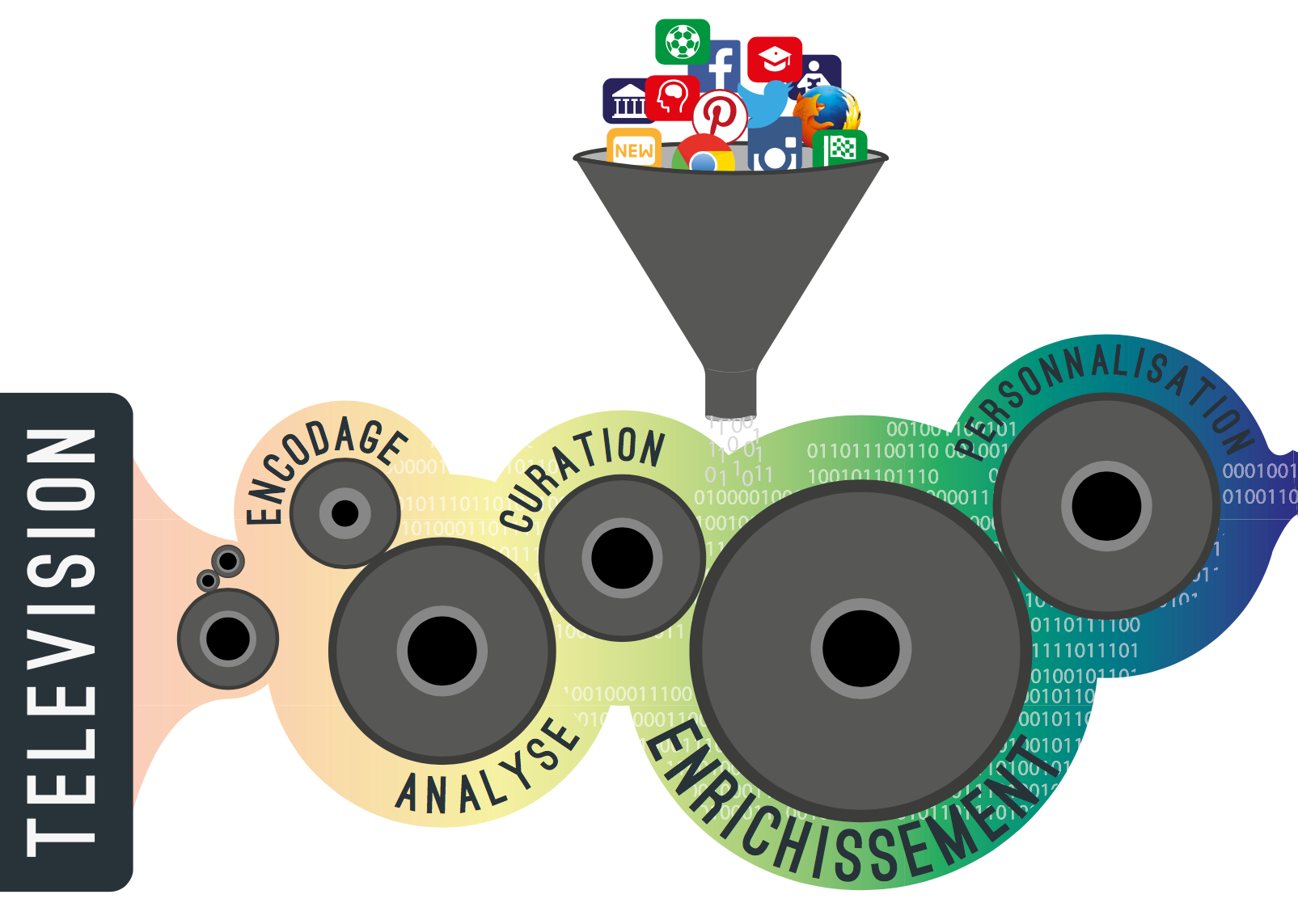

Raphaël Troncy : C’est un mouvement un peu global du secteur audiovisuel. Les chaînes TV s’aperçoivent que les gens consomment leurs programmes de moins en moins par leur écran de télévision. Ils les consomment par d’autres moyens comme le replay ou à travers des applications dédiées pour appareils mobiles, et ils font d’autres choses en même temps. Les chaînes poussent donc pour des applications innovantes. Le problème c’est que personne ne sait vraiment comment faire car personne ne connaît les attentes des utilisateurs. Au travers d’un premier projet financé dans le cadre du programme européen FP7 nommé LinkedTV, nous avions travaillé à Eurecom avec des utilisateurs pour comprendre ce qu’ils voulaient, et ce que les chaînes désiraient. Nous nous sommes donc tourné avec NexGenTV sur des applications pour second écran — comme une tablette — pour proposer du contenu enrichi aux spectateurs, tout en offrant aux chaînes TV la possibilité de garder un contenu éditorial dessus.

Même si le projet ne se terminera que l’année prochaine, avez-vous déjà mis au point des applications prometteuses ?

RT : Oui, nos technologies sont utilisées depuis l’été dernier par l’application pour tablette des chaînes beIN Sports. Elles permettent de sélectionner automatiquement les moments forts et d’apporter du contenu supplémentaire pour les matchs de foot de Ligue 1. L’utilisateur peut accéder en temps réel au fil des évènements du match comme les buts, les fautes, mais aussi qui touche la balle à quel moment, des statistiques sur chaque joueur… Nous travaillons pour proposer en plus des informations comme le replay de buts similaires par d’autres joueurs dans le championnat, ou de buts lors de matchs précédents par le joueur qui vient de marquer.

Sur cet exemple, quel est votre apport en tant que chercheur ?

RT : Les technologies que nous avons mises au point permettent plusieurs choses. Dans un premier temps, elles collectent et mettent en forme les données envoyées par des prestataires ; c’est le cas pour les kilomètres parcourus par les joueurs par exemple, ou les images de buts. C’est un challenge car les conditions du direct imposent de réaliser cela dans un laps de temps de quelques secondes qui s’écoulent entre un événement réel et le moment où il est diffusé chez l’utilisateur. Ensuite, ces technologies font de l’analyse sémantique, extraient des données des sites de joueurs, de sites officiels de la FIFA ou de la Fédération française de foot, de Wikipédia, pour les proposer en version condensée au téléspectateur.

Faites-vous également de l’analyse d’image pour, par exemple, proposer de visionner des buts similaires ?

RT : Nous le faisions dans les premiers prototypes, mais nous nous sommes rendu compte que les données des prestataires étaient suffisamment riches pour cela. En revanche, nous faisons de l’analyse d’image pour un autre cas d’usage : les débats politiques qui s’enchainent en cette période électorale. Il n’y a pas encore d’application liée à cela car nous sommes en développement. Mais nous nous sommes entraînés sur les débats des deux primaires, et nous continuons de le faire sur les débats actuels et à venir des élections présidentielles et législatives. Nous voulons pousser sur la tablette un extrait d’un discours antérieur d’un candidat pendant qu’il aborde un sujet, soit parce que c’est complémentaire, soit parce que c’est contradictoire, ou le lier avec la proposition pertinente de son programme. Nous voulons également pouvoir isoler les « meilleurs moments » basés sur l’activité parallèle sur Twitter ou sur une analyse sémantique des paroles des candidats, et proposer un résumé condensé.

Quelle valeur prend l’analyse d’image sur ce projet ?

RT : Pour les replays, l’analyse d’image nous permet de mieux segmenter une émission pour proposer une grille de lecture à un spectateur. Mais elle nous donne aussi accès à des informations particulières. Lors du dernier débat de la primaire de la droite, nous avons par exemple mesuré le temps de présence des candidats à l’écran grâce à la reconnaissance faciale programmée par apprentissage profond. Nous voulions voir s’il y avait une différence de traitement entre candidats ou si c’était équitablement réparti, comme le temps de parole qui est par ailleurs contrôlé par le CSA. Et nous nous sommes rendu compte que le choix de la réalisation se portait bien plus sur Nicolas Sarkozy que sur d’autres candidats. Alors ça peut s’expliquer, parce qu’il était très challengé par les autres candidats et que donc il était mis en avant lorsqu’il ne parlait pas. Mais ça montre aussi une application de la reconnaissance d’image pour donner aux spectateurs des clés de lecture des émissions.

L’objectif de vos technologies est donc à chaque fois de recontextualiser des évènements pour éclairer l’utilisateur ?

RT : Pas nécessairement, nous avons également un cas d’usage avec une émission éducative diffusée sur France Télévisions. Là, nous souhaitons mettre des quizz à disposition des utilisateurs par exemple, pour proposer un support pédagogique. Nous travaillons aussi à adapter la publicité aux utilisateurs pour les lectures en replay. L’idée est plutôt d’exploiter au maximum le potentiel des écrans d’appoint pour améliorer l’expérience de l’utilisateur.

[divider style= »normal » top= »20″ bottom= »20″]

NexGenTV : un consortium pour inventer la nouvelle TV

NexGenTV : un consortium pour inventer la nouvelle TV

Le projet NexGenTV associe les chercheurs d’Eurecom et de l’UMR Irisa (sous cotutelle de l’IMT). Le consortium est complété par des entreprises du secteur audiovisuel. Wildmoka est notamment en charge du développement des applications pour second écran, au côté de Envivio (racheté par Ericsson) et d’Avisto. Les partenaires travaillent en collaboration avec un club de diffuseurs associés qui fournissent le contenu audiovisuel nécessaire au développement des applications. Ce club regroupe notamment France Télévisions, TF1, Canal+, etc.

[divider style= »normal » top= »20″ bottom= »20″]

Merci pour ce point d’avancement détaillé ! J’ai ajouté le lien sur notre page de présentation du projet NexGenTV: http://www.avisto.com/rd/social-tv