Télédétection des océans : reconstruire le puzzle des données manquantes

Les mesures satellites effectuées chaque jour dépendent fortement des conditions atmosphériques, principales responsables de données manquantes. Ronan Fablet, chercheur à Télécom Bretagne, propose dans une publication scientifique une nouvelle méthode de reconstruction de la température de surface des océans pour compléter des observations partielles. Les champs ainsi reconstruits offrent une cartographie de détails homogènes à petite échelle qui sont essentiels à la compréhension de nombreux phénomènes physique et biologique.

Quel est le point commun entre la migration d’un poisson à travers l’océan, un cyclone et le Gulf Stream ? Tous peuvent être étudiés à partir d’observations satellites. Un thème apprécié par Ronan Fablet, chercheur à Télécom Bretagne qui s’intéresse notamment au traitement de données satellitaires pour la caractérisation de la dynamique des océans. Derrière cette appellation, plusieurs thèmes, dont celui de la reconstruction d’observations incomplètes. En effet, les données manquantes entachent les observations satellites et limitent la représentation de l’océan, son activité et ses interactions. Autant d’éléments essentiels à des thématiques diverses allant de l’étude de la biologie marine aux échanges océan-atmosphère influençant directement le climat. Dans une publication parue en juin 2016 dans le IEEE J-STARS[1], Ronan Fablet propose une nouvelle approche statistique d’interpolation pour combler l’absence d’observations. Retour sur le problème de l’assimilation des données en océanographie.

Température, salinité… : les paramètres cruciaux des océans

En océanographie, l’appellation de champ géophysique fait référence aux paramètres incontournables que sont la température de surface (sea surface temperature ou SST), la salinité (quantité de sel dissoute dans l’eau), la couleur de l’eau qui renseigne sur la production primaire (concentration de chlorophylle) et l’altimétrie (le relief de la surface de l’océan).

Dans sa publication, Ronan Fablet s’est concentré sur la SST. Plusieurs raisons à cela. Déjà, la SST est le paramètre le plus mesuré en océanographie. Elle bénéficie de mesures de haute précision ou haute résolution. Autrement dit, la distance séparant deux points observés est courte, de l’ordre du kilomètre, contrairement aux mesures de salinité qui ont une précision plus faible (distance de 100 km entre deux points de mesure). La température de surface est également un paramètre d’entrée fréquemment utilisé pour la conception de modèles numériques étudiant les interactions océan/atmosphère. En effet, de nombreux transferts thermiques s’effectuent entre les deux. Un exemple évident : les cyclones. Ces derniers pompent de la chaleur dans les régions chaudes des océans pour s’alimenter. Par ailleurs, la température est également essentielle à la détermination des grandes structures océaniques. Elle permet de cartographier les courants de surface à petite échelle.

Mais comment un satellite permet-il de mesurer la température de surface de l’eau ? Comme un matériau l’océan va réagir différemment à une longueur d’onde donnée. « Pour étudier la SST, on peut par exemple utiliser un capteur infrarouge qui mesure dans un premier temps une énergie. Il existe ensuite une loi de conversion vers la température », explique Ronan Fablet.

Palier au problème des données manquantes en télédétection

Contrairement aux satellites géostationnaires qui tournent à la même vitesse que la Terre sur elle-même, les satellites défilants font le tour de notre planète généralement en un peu plus d’1h30. Cela leur permet de survoler plusieurs points terrestres au cours d’une journée. Ils construisent ainsi des images par accumulation. Mais certains points des océans ne sont pas vus. En effet, l’origine principale des données manquantes est la sensibilité des capteurs satellitaires aux conditions atmosphériques, et dans le cas des mesures infrarouges les nuages obstruent les observations. « Dans une zone prédéfinie, il est parfois nécessaire d’accumuler deux semaines d’observations pour bénéficier de suffisamment d’informations, et envisager une reconstruction du champ étudié », précise Ronan Fablet. A cela s’ajoute une évidente hétérogénéité de la couverture nuageuse. « Le taux de données manquantes sur certaines zones peut aller jusqu’à 90% », développe le chercheur.

L’absence de données est un véritable challenge. Les modélisateurs doivent trouver un compromis entre la généricité du modèle d’interpolation et sa complexité calculatoire. Le problème étant que les équations caractérisant le mouvement des fluides, tel que l’eau, ne sont pas évidentes à traiter. C’est pourquoi les modèles sont généralement simplifiés.

Une nouvelle approche d’interpolation

Selon Ronan Fablet, les techniques utilisées ne tirent pas complètement parti de toutes les informations disponibles. L’approche proposée par le chercheur s’affranchit de ces limites : « on possède actuellement 20 à 30 ans de données de SST. L’idée est que parmi ces échantillons il y a une représentation implicite de la variation de l’océan qui va permettre une interpolation. A partir de ces connaissances, on doit pouvoir reconstruire des observations partielles actuelles ».

L’idée générale de la méthode mise en place par Ronan Fablet s’articule autour du principe d’apprentissage. Si une situation observée aujourd’hui correspond à une situation antérieure, alors il est possible d’utiliser les observations passées pour reconstruire les données actuelles. Il s’agit d’une approche par analogie.

Mise en place du modèle

Dans sa publication, Ronan Fablet utilise donc une modélisation basée sur l’analogie. Il caractérise ici la SST à partir d’une loi qui représente au mieux ses variations spatiales. Le choix de la loi utilisée permet d’être au plus proche de la réalité.

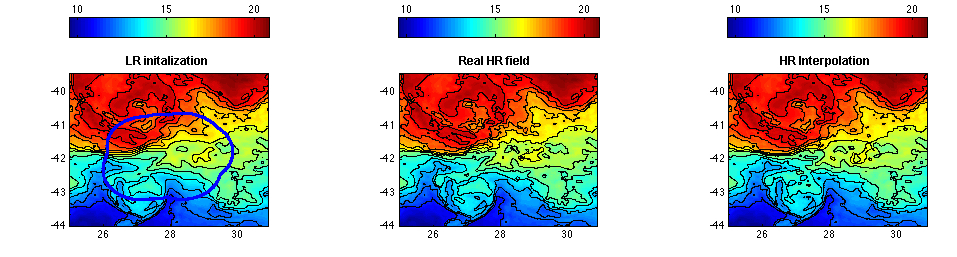

Dans son étude, Ronan Fablet utilise des observations de SST de basse résolution (distance de 100 km entre deux observations). A faible résolution, l’interpolation optimale est habituellement favorisée. L’objectif de cette dernière étant de limiter l’erreur de reconstruction (différence entre le champ simulé et celui observé) au détriment du détail à petite échelle. L’image ainsi obtenue a un aspect lisse. Cependant, au moment de l’interpolation, le chercheur a décidé de maintenir un haut niveau de détail. Seule incertitude, la localisation du dit détail sur la carte. C’est pourquoi il a favorisé une interpolation stochastique. Celle-ci permet de simuler plusieurs exemples qui vont placer à différents endroits le détail. En définitive, cette approche lui permet de créer des champs de SST avec un même niveau de détail partout mais avec la contrainte locale que l’erreur de reconstruction ne sera pas meilleure que celle de la méthode optimale.

« La part d’énergie des océans sur des distances inférieures à 100 km est très importante dans le bilan global. A ces échelles, il y a également beaucoup d’interactions entre la physique et la biologie. Par exemple, les bancs de poissons et les structures de plancton s’organisent à moins de 100 km. Maintenir un niveau de détail à ces petites échelles, c’est aussi dans le but de mieux mesurer l’impact de la physique sur des processus écologiques », explique Ronan Fablet.

Le cercle bleu représente la zone de données manquantes. Les cartes représentent des variations de SST à basse résolution à partir d’un modèle (à gauche), à haute résolution à partir d’observations (au centre) et à haute résolution par le modèle de la publication (à droite).

De nouvelles méthodes en perspective avec le deep learning

Une autre méthode de modélisation émerge depuis peu et utilise les techniques du deep learning. Le modèle ainsi conçu apprend à partir de photographies des océans. Selon Ronan Fablet cette méthode est pertinente : « elle reprend l’idée d’analogie c’est-à-dire l’exploitation du passé pour trouver des situations similaires à aujourd’hui. L’avantage est de pouvoir réaliser un modèle basé sur de nombreux paramètres calibrés par des gros jeux de données d’apprentissage. Elle s’avèrerait particulièrement intéressante pour la reconstruction haute résolution des données manquantes de champs géophysiques observés par télédétection ».

[1] Journal of Selected Topics in Applied Earth Observations and Remote Sensing. Journal à comité de lecture de l’IEEE.

À lire également sur le blog

Trackbacks (rétroliens) & Pingbacks

[…] Télédétection des océans : reconstruire le puzzle des données manquantes […]

[…] Télédétection des océans : reconstruire le puzzle des données manquantes […]

[…] Quel est le point commun entre la migration d’un poisson à travers l’océan, un cyclone et le Gulf Stream ? Tous peuvent être étudiés à partir d’observations satellites. Un thème apprécié par Ronan Fablet, chercheur à Télécom Bretagne qui s’intéresse notamment au traitement de données satellitaires pour la caractérisation de la dynamique des océans. Derrière cette appellation, plusieurs thèmes, dont celui de la reconstruction d’observations incomplètes. En effet, les données manquantes entachent les observations satellites et limitent la représentation de l’océan, son activité et ses interactions. Autant d’éléments essentiels à des thématiques diverses allant de l’étude de la biologie marine aux échanges océan-atmosphère influençant directement le climat. Dans une publication parue en juin 2016 dans le IEEE J-STARS[1], Ronan Fablet propose une nouvelle approche statistique d’interpolation pour combler l’absence d’observations. Retour sur le problème de l’assimilation des données en océanographie. [Lire la suite] […]

[…] Télédétection des océans : reconstruire le puzzle des données manquantes […]

[…] A lire également sur I’MTech : Télédétection des océans : reconstruire le puzzle des données manquantes […]

[…] Télédétection des océans : reconstruire le puzzle des données manquantes […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !