Ces technologies qui décryptent le fonctionnement du cerveau

L’étude du fonctionnement du cerveau passe par différentes techniques : électro-encéphalographie, magnéto-encéphalographie, IRM fonctionnelle, spectroscopie… Le traitement de ces signaux et leur interprétation permettent ensuite d’évaluer les processus cognitifs mis en jeu. L’EEG et l’IRM sont les deux techniques les plus couramment utilisées en sciences cognitives. Leurs performances suscitent à la fois espoirs et inquiétudes. Quel est l’état actuel de ces travaux d’analyse des fonctions cérébrales, et quelles sont leurs limites ?

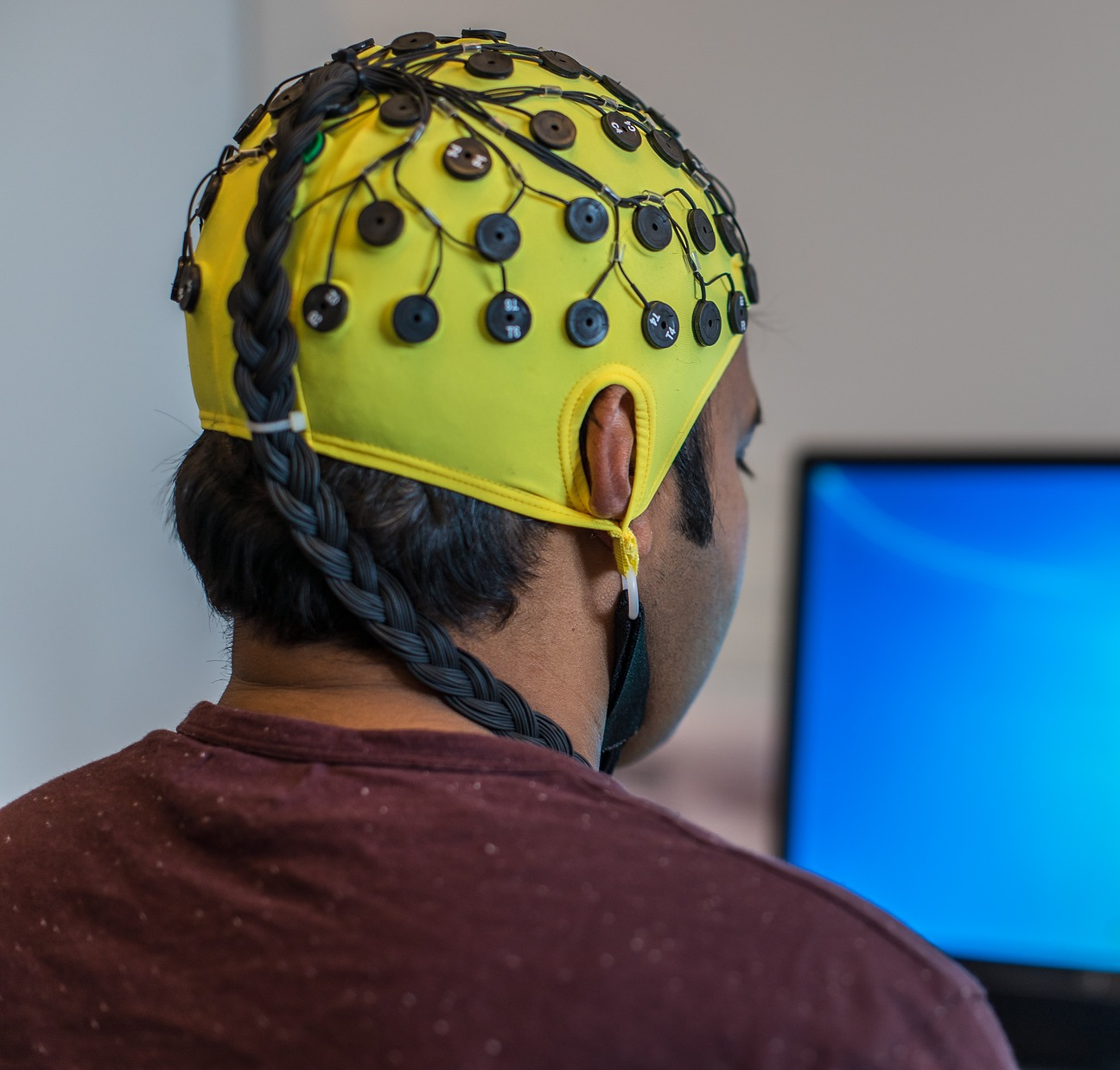

Nesma Houmani est spécialisée dans l’analyse et le traitement des signaux électro-encéphalographiques (EEG) à Télécom SudParis. Ces modifications électriques sont générées par l’activité des neurones cérébraux, et détectables à la surface du crâne. L’enregistrement se fait par l’intermédiaire d’un casque comportant des électrodes placées à des endroits stratégiques. L’avantage de l’EEG est d’être peu coûteux, facilement accessible, et peu invasif pour les sujets se prêtant aux études. Son signal est toutefois complexe car il est composé d’oscillations qui correspondent à l’addition d’un état d’activité de base du cerveau lorsque le patient est au repos et éveillé, de phénomènes ponctuels liés aux activations engendrées par le test, et d’un bruit de fond variable, notamment causé par les mouvements involontaires du sujet.

Le niveau de bruit dépend entre autres du type d’électrodes utilisées : électrodes sèches ou avec du gel, ces dernières réduisant les signaux d’origine non cérébrale mais imposant un temps long pour la pose du casque, des risques d’allergies et un bon shampoing après l’examen, ce qui rend plus difficile la réalisation de tests en dehors de l’hôpital. Des électrodes sèches voient le jour dans les hôpitaux, mais elles enregistrent des signaux très bruités.

La chercheuse de Télécom SudParis s’aide d’algorithmes de machine learning et d’intelligence artificielle pour extraire des marqueurs EEG : « j’utilise la théorie de l’information couplée à des méthodes d’apprentissage statistique pour traiter des séries temporelles EEG de quelques millisecondes ». La théorie de l’information postule que plus l’entropie d’un signal est élevée, plus il contient d’information. Autrement dit, plus la probabilité de survenue d’un événement est faible, plus celui-ci contient d’information, donc plus il a de chances d’être pertinent. Les travaux de Nesma Houmani permettent de retirer les signaux parasites du tracé, et ainsi de mieux interpréter les données enregistrées par l’EEG.

Une étude publiée en 2015 a montré que cette technique permet de mieux caractériser le signal EEG pour la détection de la maladie d’Alzheimer. La modélisation statistique permet de tenir compte des interactions entre différentes zones du cerveau dans le temps. Dans le cadre de ses recherches sur l’attention visuelle, Nesma Houmani se sert notamment de l’EEG couplé à un dispositif d’eye-tracking pour déterminer comment un sujet s’engage et se désengage d’une tâche : « Les participants doivent observer des images sur un écran et effectuer différentes actions selon l’image présentée. Une caméra identifie la zone de fixation de l’œil, et permet de reconstituer les mouvements des yeux » explique-t-elle. D’autres équipes utilisent l’EEG pour la reconnaissance des émotions, ou encore pour la compréhension des mécanismes décisionnels.

L’EEG apporte des données intéressantes car sa résolution temporelle est de quelques millisecondes. Elle est très utilisée pour des applications d’interfaces cerveau-machine permettant d’observer l’activité cérébrale d’une personne en temps réel ou avec un décalage de quelques secondes seulement. « Cependant l’EEG s’avère limité au niveau de la résolution spatiale » explique Nesma Houmani. En effet, les électrodes sont placées à la surface du crâne, en deux dimensions en quelque sorte, alors que les sillons du cortex forment des replis dans les trois dimensions, et que des activations peuvent également provenir de zones plus profondes du cerveau. De plus, chaque électrode mesure la somme de l’activité synchrone d’une assemblée de neurones.

L’outil le plus populaire actuellement : l’IRMf

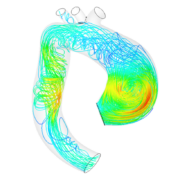

À l’inverse, l’IRM fonctionnelle (IRMf) possède une très bonne résolution spatiale, mais une mauvaise résolution temporelle. Elle est très souvent utilisée dans les études neuroscientifiques récentes, mais elle est coûteuse et son accès est limité par la quantité d’appareils disponibles. Par ailleurs le bruit important qu’elle émet en fonctionnement, et la position allongée dans une sorte de tube sont deux éléments potentiellement stressants pour les participants. Une reconstruction de l’activité cérébrale en temps réel est obtenue par la détection d’un signal magnétique lié à la quantité de sang apportée par les micro-vaisseaux à un instant donné, superposé à des coupes anatomiques 3D. Si les activations sont situées avec précision, les variations hémodynamiques surviennent quelques secondes après le stimulus — ce qui explique une résolution temporelle moins performante que l’EEG.

L’IRMf produit des images de coupe du cerveau avec une bonne résolution spatiale, mais une mauvaise résolution temporelle.

Nicolas Farrugia a conduit plusieurs études en IRMf dans le domaine de la musique. Il travaille actuellement à IMT Atlantique sur les applications du machine learning et de l’intelligence artificielle aux neurosciences. « Deux paradigmes sont principalement étudiés en neurosciences : l’encodage et le décodage. Le premier cherche à prédire l’activité cérébrale générée par un stimulus, le second à décrypter le stimulus à partir de cette activité » explique le chercheur. Une étude publiée en 2017 a montré les possibilités de l’IRMf associée à l’intelligence artificielle dans le domaine du décodage. Des chercheurs ont fait visionner des vidéos pendant plusieurs heures à des sujets placés dans un appareil d’IRM. Un modèle a ensuite été développé grâce au machine learning, capable de reconstituer une image basse définition de ce que le participant voyait à partir des signaux enregistrés dans son cortex visuel. L’IRMf est donc une technique particulièrement intéressante pour étudier les mécanismes cognitifs, et de nombreux chercheurs y voient la clé de la compréhension du cerveau humain, mais elle a cependant ses limites.

Des problèmes de reproductibilité

Les protocoles de recherche ont récemment évolué, comme l’explique Nicolas Farrugia : « la majorité de la littérature des neurosciences cognitives s’est faite à partir de modèles statistiques simples basés sur des contrastes en IRM fonctionnelle. On soustrayait les activations enregistrées dans le cerveau pour deux conditions expérimentales A et B — lecture versus repos par exemple. » Mais plusieurs problèmes ont amené les chercheurs à modifier cette approche. « Les neurosciences vivent une grosse crise de la reproductibilité » reconnaît Nicolas Farrugia. Différentes limites ont été identifiées dans les publications : des petits effectifs, un niveau de bruit élevé, et une analyse indépendante de chaque région cérébrale, sans prendre en compte d’éventuelles interactions ou l’intensité relative d’activation de chaque zone.

« Ces problèmes de reproductibilité poussent les chercheurs à changer de méthodologie, et à passer d’une technique d’inférence dans laquelle toutes les données disponibles étaient utilisées pour obtenir un modèle non généralisable, à une technique de prédiction, où le modèle apprend sur une partie des données, et est ensuite testé sur le reste. » Cette approche, sur laquelle est basé le machine learning, permet de vérifier la pertinence du modèle par rapport à la vérité terrain. « Grâce à l’intelligence artificielle, apparaissent des méthodes de calcul computationnel qui étaient impossibles avec les statistiques classiques. C’est ce qui permettrait à terme de prédire à quel type d’image ou à quel morceau de musique pense la personne à partir de son activité cérébrale. »

Malheureusement il existe également des problèmes de reproductibilité dans le traitement du signal par le machine learning. Cette technique, basée sur des réseaux de neurones artificiels, est la plus populaire aujourd’hui car elle est très performante sur de nombreuses applications. Son utilisation nécessite l’ajustement de centaines de milliers de paramètres par des méthodes d’optimisation. Les chercheurs ont tendance à ajuster les paramètres du modèle développé quand ils l’évaluent, tout en réitérant les tests sur les mêmes données, faussant ainsi la généralisation des résultats. Pour la partie analyse et détection du signal, l’utilisation du machine learning génère une autre difficulté, celle de la capacité à interpréter les résultats. En effet la connaissance des mécanismes d’apprentissage profond est actuellement très limitée, et fait l’objet d’un champ de recherche à part entière. La compréhension du fonctionnement des neurones humains pourrait donc venir de celle du fonctionnement des réseaux de neurones profonds artificiels. Une drôle de mise en abyme !

Article rédigé par Sarah Balfagon, pour I’MTech.

À lire sur I’MTech

Trackbacks (rétroliens) & Pingbacks

[…] menés sur la capacité des algorithmes à être expliqués. Parmi ceux-ci, Christine Balagué et Nesma Houmani (chercheuse à Télécom Sud Paris) s’intéressent à des algorithmes d’analyse d’électroencéphalographie (EEG). Leur […]

[…] pour les analyses, mais aussi léger et facile à déployer pendant le confinement » indique Nicolas Farrugia, chercheur en apprentissage machine et deep learning à IMT Atlantique. Confinement oblige, il […]

[…] À lire sur I’MTech : Ces technologies qui décryptent le fonctionnement du cerveau […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !