Pourrons-nous bientôt commander les machines par de simples gestes ?

Débuté en mai 2017, le projet européen « Silense » veut redéfinir notre façon d’interagir avec les machines. En utilisant une technologie ultrason proche du sonar, les chercheurs et industriels de la collaboration misent sur la reconnaissance de mouvement en 3D. Cela pourrait permettre de commander nos smartphones ou nos maisons simplement par le geste, sans contact physique avec une surface tactile.

Débuté en mai 2017, le projet européen « Silense » veut redéfinir notre façon d’interagir avec les machines. En utilisant une technologie ultrason proche du sonar, les chercheurs et industriels de la collaboration misent sur la reconnaissance de mouvement en 3D. Cela pourrait permettre de commander nos smartphones ou nos maisons simplement par le geste, sans contact physique avec une surface tactile.

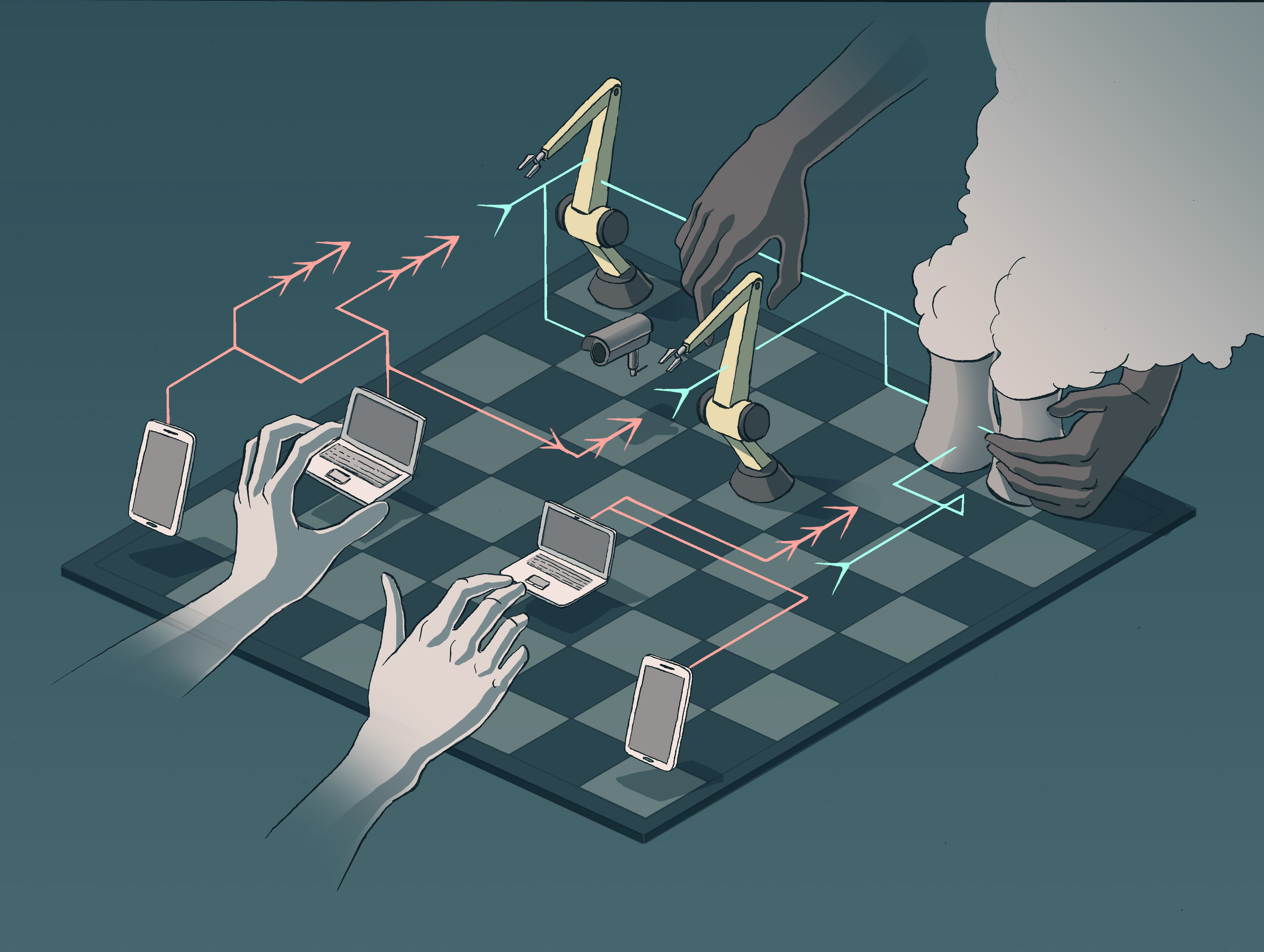

Diminuer le son de sa télévision depuis son canapé simplement en baissant la main. Commander la fermeture des volets de sa chambre en serrant des doigts. Indiquer au GPS de sa voiture la bonne destination en levant le pouce. Ces scènes semblent tirées d’un film de science-fiction. Pourtant, elles constituent l’objectif bien réel du projet européen H2020 nommé « Silense » — pour (Ultra)Sound Interfaces and Low Energy iNtegrated SEnsors. D’une durée de 3 ans, il rassemble 42 partenaires académiques et industriels à travers huit pays du continent. Ce consortium — particulièrement conséquent, même pour un projet H2020 — travaillera de 2017 à 2020 au développement des nouvelles interfaces entre hommes et machines basée sur les ultrasons.

« Ce que nous voulons faire, c’est remplacer les commandes tactiles par des commandes faites par l’utilisateur à distance en bougeant ses mains, ses bras ou son corps » simplifie Marius Preda, chercheur à Télécom SudParis, partenaire du projet. Pour cela, les scientifiques développeront une technologie similaire au sonar. Une source audio émet un son inaudible qui se propage dans l’air. Lorsque l’onde rencontre un obstacle, elle rebondit et revient vers la source. Des récepteurs placés au même niveau que l’émetteur enregistrent le temps de parcours de l’onde et en déduisent la distance entre la source et l’obstacle. Une carte en 3D de l’environnement peut ainsi être créée. « C’est le même principe que pour une échographie » illustre le chercheur.

Dans le cas du projet Silense, la source sera constituée de plusieurs émetteurs, et les récepteurs seront bien plus nombreux que dans le cas d’un sonar. Le but est d’améliorer la perception des obstacles, et donc la résolution de l’image 3D réalisée. Cela devrait permettre de détecter des variations de formes plus fines, et donc des gestes plus complexes que ce qu’il est actuellement possible de faire. « Aujourd’hui, nous pouvons voir si une main est ouverte ou fermée, mais nous ne pouvons pas différencier une main avec un doigt dressé ou deux doigts dressés et collés » constate Marius Preda.

Télécom SudParis pilote la partie logicielle du projet. La mission de ses chercheurs consiste à développer des algorithmes de traitement d’image pour reconnaître les gestes effectués par les utilisateurs. En utilisant des réseaux de neurones pour faire de l’apprentissage profond, les scientifiques veulent constituer un dictionnaire de gestes bien distincts. Ceux-ci devront être reconnaissables par les détecteurs ultrasons quel que soit l’orientation de la main ou du bras par rapport au capteur.

La tâche n’est pas aisée : il faudra dans un premier temps étudier les gestes discriminants ; c’est à dire ceux que l’algorithme ne peut pas confondre. Puis viendront ensuite des étapes de réduction du bruit pour affiner la détection des formes, et ce de façon parfois spécifique au cas d’utilisation — un capteur dans le mur d’une maison n’aura pas les mêmes défauts que celui dans la portière d’une voiture. Enfin, les chercheurs devront également prendre en compte l’unicité de chaque utilisateur. Le même signe n’est pas accompli de la même façon par deux personnes, ni à la même vitesse.

« Notre principal défi est de développer des logiciels qui arrivent à détecter le début et la fin d’un mouvement pour n’importe quel utilisateur » souligne Marius Preda, tout en avançant la difficulté d’une telle tâche due à la fluidité des gestes chez les humains : « Nous n’annonçons pas que nous débutons un geste, ni que nous le finissons. Il faut donc arriver à parfaitement segmenter les actions de l’utilisateur dans une chaîne de gestes. »

Vers l’interaction humain-machine de demain

Pour relever ce challenge, les chercheurs de Télécom SudParis travailleront en étroite collaboration avec les partenaires en charge de la partie matérielle. Durant les trois ans du projet, le consortium a bon espoir de mettre au point de nouvelles générations de capteurs, plus petits. Cela permettra d’augmenter un peu plus, sur une surface égale, le nombre d’émetteurs et de récepteurs, et donc la résolution de l’image. Cette innovation, couplée à de nouveaux algorithmes de traitement des images, devrait sensiblement augmenter le catalogue de formes reconnues par ultrason.

Le projet Silense est particulièrement scruté par les constructeurs automobiles et d’objets connectés. Une interface homme-machine utilisant les ultrasons présente plusieurs avantages. Par rapport à l’interface standard actuelle — le toucher — elle améliorerait la sécurité dans les véhicules en diminuant l’attention nécessaire pour appuyer sur un bouton ou sur un écran tactile. Dans le cas des smartphones ou des maisons intelligentes, ce serait un plus grand confort d’utilisation pour les consommateurs.

L’interface ultrason proposée ici doit également être comparée à sa principale concurrente : l’interaction par reconnaissance visuelle — le caméras Kinect par exemple. Pour Marius Preda, l’ultrason permet de s’affranchir des problèmes de luminosité rencontrés par la vidéo dans des conditions de surexposition (forte luminosité en voiture par exemple) ou de sous-exposition (intérieur d’une maison de nuit). De plus, la segmentation des formes comme les mains est plus facile en imagerie 3D acoustique. « Si votre main a la même couleur que le mur derrière vous, la caméra aura du mal à reconnaître votre geste » explique le chercheur.

Silense porte donc des espoirs sérieux de faire émerger une nouvelle façon d’interagir avec les machines de nos quotidiens. D’ici la fin du projet, le consortium souhaite mettre en place trois démonstrateurs : un dans le cas d’une maison intelligente, un intégré à une voiture, et le dernier embarqué dans un écran comme celui d’un smartphone. Si ces premières preuves de concept s’avéraient concluantes, il ne faudra alors plus être surpris de voir des conducteurs faire de grands gestes dans leurs voitures !

Trackbacks (rétroliens) & Pingbacks

[…] Pourrons-nous bientôt commander les machines par de simples gestes ? […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !