Les mathématiques appliquées au secours des données onéreuses

Le 11 mai 2016, une nouvelle chaire en mathématiques appliquées était lancée à Mines Saint-Étienne. Baptisée « Optimisation et quantification d’incertitudes pour les données onéreuses » (Oquaido), celle-ci concrétise dix années de recherche de l’école stéphanoise sur la problématique du traitement des données à forte valeur. Olivier Roustant, responsable de la chaire, nous explique les enjeux d’une telle chaire.

Lorsque l’on parle de données onéreuses, de quel genre de données s’agit-il ?

Olivier Roustant : Il s’agit de données coûteuses en temps ou en argent. Elles sont le résultat d’expériences physiques, ou d’expériences « numériques » obtenues par un grand code de calcul industriel. Par exemple, une simulation de crash-test automobile par ordinateur dure plusieurs heures. Les données numériques onéreuses résultent aussi souvent de couplages entre plusieurs codes. C’est le cas des couplages multi-physiques, par exemple fluide et mécanique en aéroélasticité.

Pourquoi ces données ont particulièrement besoin d’une optimisation et d’une quantification des incertitudes liées ?

OR : Une fois qu’un bureau d’études ou un centre de recherche bénéficie de simulations numériques de son objet de recherche, il entre dans une phase décisionnelle : des questions d’optimisation et de calcul de risque au moyen de la simulation deviennent alors le quotidien des ingénieurs. Dans le contexte des données onéreuses, les approches habituelles se heurtent au nombre limité d’expériences réalisables. Pour pallier ce problème, on construit un ou plusieurs modèles de nature mathématique et plus rapide à évaluer, réalisant une approximation des données disponibles. Ce modèle sert de guide pour proposer de nouvelles expériences.

Quels verrous scientifiques posent encore problème pour bien appréhender ces incertitudes et pourquoi ?

OR : Du point de vue des mathématiciens, trois grands verrous scientifiques existent. Il y a d’abord des difficultés liées à la diversité des données manipulées qui peuvent être des nombres (tels que l’épaisseur d’une pièce), des catégories (comme le type de matériau), voire des fonctions du temps (comme une production cumulée) ou de l’espace (comme un champ de porosité dans le sous-sol). Ensuite, le nombre de variables à analyser dans les problèmes que nous considérons, qui peut aller de la dizaine à la centaine, pose des difficultés mathématiques : il faut modéliser et décider dans des espaces de grande dimension. Enfin, pour avoir une chance de résoudre des problèmes difficiles nous devons être capables de prendre en compte dans nos méthodologies un maximum de connaissances a priori sur le problème. Par exemple, lorsque nous modélisons un cumul de polluants ou de production, nous savons a priori qu’il est toujours croissant, ce qui a un impact fort sur les incertitudes prédites. Notre dernier verrou scientifique est donc de prendre en compte l’ensemble des contraintes spécifiques aux problèmes qui nous sont soumis.

Comment la chaire Oquaido peut-elle vous permettre de lever ces verrous ?

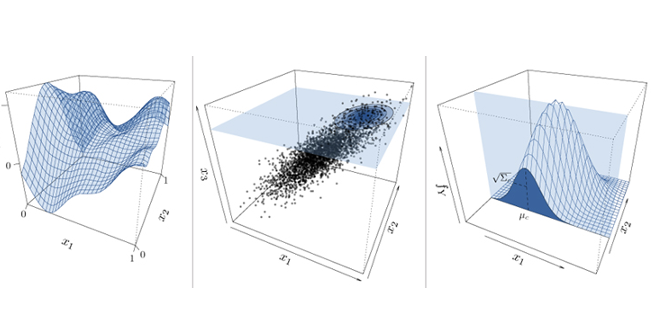

OR : Au plan scientifique, la chaire souhaite développer son expertise dans la construction de modèles statistiques et d’algorithmes mathématiques pour la décision, acquise lors de précédents projets avec consortiums. En particulier, nous voulons poursuivre le développement de la modélisation par krigeage dans les directions des verrous dont nous venons de parler. Le krigeage est une méthode statistique permettant à la fois de bien approcher les données disponibles et de donner une incertitude sur les zones non explorées de l’espace des variables. Il présente également l’avantage de nous donner un cadre mathématique général, celui des processus aléatoires, pour répondre aux questions qui nous sont posées de manière rigoureuse mais néanmoins souple. Plus généralement, la chaire souhaite s’appuyer sur le dynamisme des domaines de l’apprentissage statistique et de l’apprentissage automatique (machine learning), en favorisant les échanges avec les chercheurs de ces domaines à l’international.

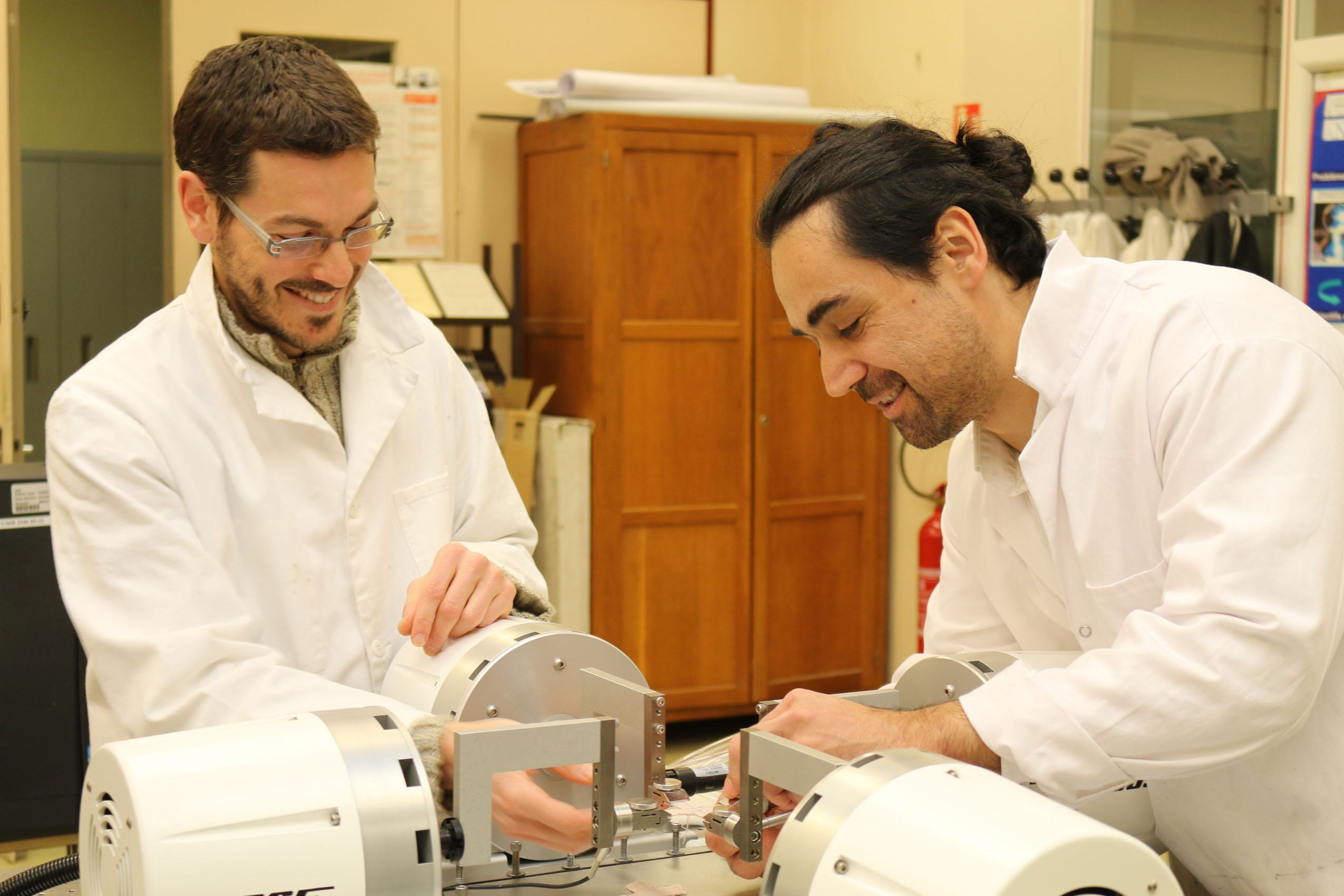

Comment prédire le résultat au crash-test d’un prototype lorsqu’une simulation numérique dure 10h ? Tel est l’un des enjeux du traitement de données onéreuses.

Quelle est l’expertise scientifique de Mines Saint-Étienne dans ce domaine ?

OR : La chaire Oquaido est l’aboutissement de dix ans de recherche à Mines Saint-Étienne sur la question du traitement mathématique de données onéreuses, initiés par deux consortiums industriels. Le projet Deep Inside Computer Experiments (DICE) tout d’abord, piloté par Mines Saint-Étienne de 2006 à 2009, a regroupé cinq partenaires industriels de secteurs variés (énergie, transports, étude des risques) et quatre partenaires académiques. Il a permis de poser des bases pour la suite et a débouché en particulier sur la création d’une suite logicielle en langage libre R, qui fait référence aujourd’hui encore avec plus de 20 téléchargements par jour. Cet investissement a été poursuivi avec succès par le consortium ReDICE sous un format voisin, piloté par l’université de Berne de 2011 à 2015. La nature collaborative du projet a été renforcée par une diffusion facilitée de plus d’une vingtaine de publications dans des revues internationales de premier plan, quatre nouvelles briques logicielles produites, et une volonté de transfert vers les participants.

Au travers de ces consortiums Mines Saint-Étienne a acquis une expertise reconnue parmi les acteurs académiques et industriels, en particulier dans la modélisation par krigeage. Il faut rappeler au passage que cette technique tire ses racines de la géostatistique développée par Georges Matheron à l’Ecole des Mines de Paris dans les années 1960.

Que vous apporteront les partenaires industriels et académiques ?

OR : La chaire a pour ambition de réaliser des avancées mathématiques pour le traitement de données onéreuses, guidées par des cas tests industriels. Elle est organisée sous la forme d’un projet collaboratif, mettant en commun des moyens financiers et humains. Les partenaires de recherche technologique ou les industriels (BRGM, CEA, IFPEN, IRSN, Safran, Storengy) apportent des moyens financiers, des questions pratiques sous la forme de cas tests, ainsi qu’une expertise métier très importante pour bien poser les problèmes. Les partenaires académiques (Mines Saint-Etienne, École centrale de Lyon, université Nice Sophia Antipolis, université Toulouse III – Paul Sabatier) apportent leur savoir-faire mathématique. Les synergies entre tous les participants sont encouragées et favorisées par le co-encadrement de travaux de recherche doctoraux ou post-doctoraux, les travaux communs sur les cas tests, l’organisation de journées scientifiques semestrielles, de workshops, et la mise en place de formations sur les aspects mathématiques et logiciels. La dynamique de recherche sera également stimulée par des invitations régulières de chercheurs à l’international.

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !