C’est au cours d’une thèse autour de l’indexation multimédia à l’université de Lille que Julien Tierny, ingénieur diplômé d’IMT Nord-Europe, est confronté pour la première fois à des problématiques de représentation des données. L’indexation multimédia est le principe au centre des moteurs de recherche de données multimédias, comme Google Image. Afin de répondre à une requête rapidement, il faut pouvoir comparer tout aussi rapidement les données et donc en trouver des descripteurs très concis. C’est dans ce contexte qu’il commence à s’intéresser à l’analyse de données, et plus particulièrement aux descripteurs de nature topologique.

Ce type d’analyse permet de trouver des informations structurelles, de formes, au sein de volumes massifs de données. Toutes ces données peuvent être représentées comme un nuage de milliards de points – avec des informations attachées à chacun de ces points – dont le jeune chercheur essaie de comprendre la forme grâce à des algorithmes. Dans des séries temporelles par exemple, les algorithmes employés sont capables d’extraire de manière robuste des phénomènes périodiques comme des phénomènes saisonniers en météo.

Des disciplines scientifiques variées

À l’issue de sa thèse, Julien Tierny poursuit un post-doctorat de deux ans au Scientific Computing And Imaging Institute de l’université de l’Utah, aux États-Unis, un laboratoire reconnu dans la visualisation et l’analyse de données scientifiques. Cette expérience aux côtés de l’expert Valerio Pascucci convainc l’informaticien de se focaliser définitivement sur l’exploration des méthodes topologiques.

En 2014, lorsqu’il rejoint le LIP6 de Sorbonne Université, il profite de la transdisciplinarité offerte par l’institution pour tester ces méthodes d’analyse sur des données à grande échelle de domaines scientifiques variés. Julien Tierny travaille ainsi sur des données de chimie, d’océanographie ou encore d’astrophysique, collectées par des capteurs ou simulées par ordinateur. Cette même approche s’applique également à l’analyse d’images, issues d’imagerie médicale par exemple.

La construction d’une équipe pour l’analyse de données massives

Pour ces analyses de données à grande échelle, Julien Tierny collabore d’abord avec des collègues experts en calcul haute performance. Mais très vite, il s’attelle à trouver des financements pour recruter et soutenir sa propre activité. « Peu de temps après, les planètes se sont alignées : de nombreux industriels se sont intéressés à l’analyse topologique de données massives, ce qui a permis d’initier des partenariats – avec Total ou EDF par exemple – et de lancer l’activité », relate-t-il.

Les nombreuses collaborations qui s’ensuivent donnent à Julien Tierny l’occasion de faire mûrir ses projets. En 2019, il décroche une ERC Consolidator Grant pour une durée de cinq ans. Son objectif : faire l’analyse de grandes collections de données massives, c’est-à-dire traiter plusieurs jeux de données de milliard de points. Ce projet, démarré en 2020, lui a permis d’agrandir son équipe à une dizaine de membres et de ne plus « courir après les financements. Pendant la durée du projet, nous pouvons dédier 100% de notre énergie au travail de recherche. »

Le « fléau » des collections de données massives

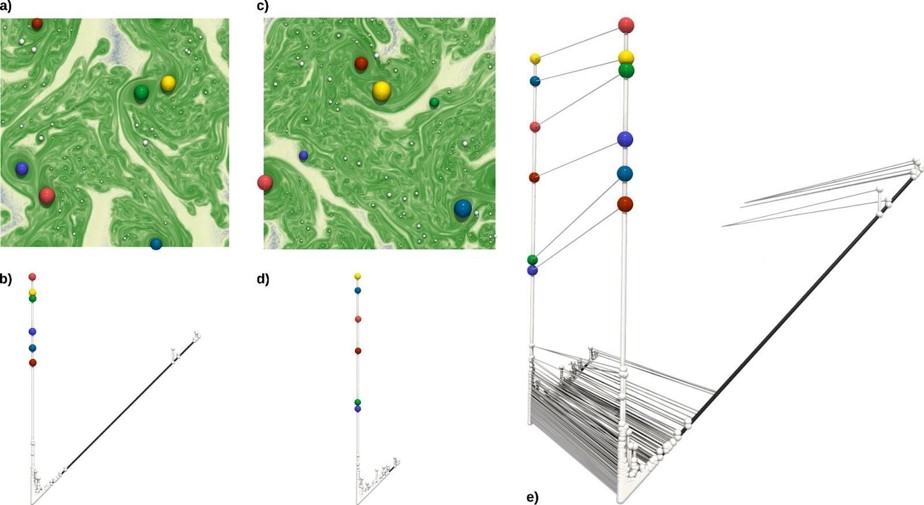

Les collections de jeux de données, également qualifiées de « données d’ensemble », sont généralement issues de simulations numériques, et représentent la multitude de scénarios possibles dans une simulation. À l’instar de la recherche fondamentale, les industriels effectuent également – dans la perspective d’optimiser leurs procédés – des simulations conditionnées par des paramètres de fonctionnement spécifiques. Pour atteindre un fonctionnement optimal, chaque paramètre est très sensiblement modifié, de manière itérative. Les combinaisons entre tous les paramètres d’entrée sont autant de scénarios qui fournissent des jeux de données de taille massive.

L’enjeu de l’analyse sur des données d’ensemble est d’identifier s’il y a des points communs entre les résultats malgré des paramètres qui diffèrent en entrée, ou s’il y a au contraire des plages de paramètres en entrée qui provoquent des régimes très spécifiques. L’analyse topologique est un moyen de comprendre cette population de jeux de données en « visualisant » les motifs qui en émergent.