La cyberdéfense veut reprendre l’initiative

Entre attaquants et défenseurs, qui est en avance ? En cybersécurité, les assaillants ont longtemps été considérés comme vainqueurs par défaut. Pourtant, les infrastructures savent de mieux en mieux se protéger. S’il reste du chemin à faire, les choses ne sont pas aussi déséquilibrées qu’il n’y paraît. La recherche fournit notamment de belles réponses en cyberdéfense permettant d’assurer sécurité et résilience des systèmes informatiques.

[divider style= »normal » top= »20″ bottom= »20″]

Cet article fait partie de notre dossier Cybersécurité : nouveaux temps, nouveaux enjeux

[divider style= »normal » top= »20″ bottom= »20″]

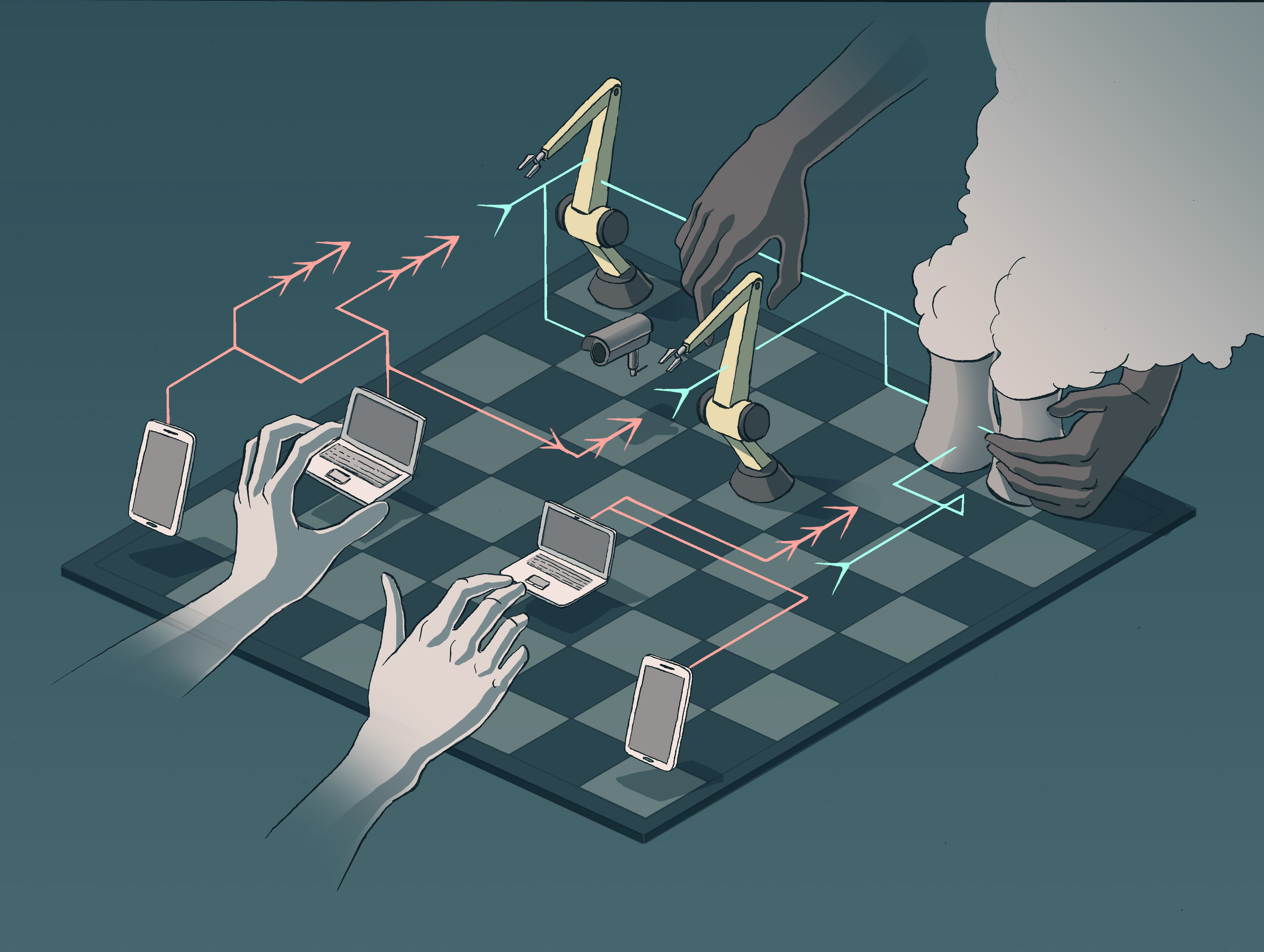

Au début d’une partie d’échecs, les blancs ont toujours l’initiative. Telle est la règle cruelle pour les noirs, souvent contraints de défendre durant les premières minutes du jeu. Il en va de même dans le monde de la cybersécurité : l’attaquant a, tel le joueur des pièces blanches, le premier coup. « Les choix sont pour lui, et le défenseur doit suivre sa stratégie ce qui le met par défaut dans une situation d’infériorité » constate Frédéric Cuppens, chercheur en cybersécurité à IMT Atlantique. Cet état des choses définit les stratégies adoptées par les entreprises et les éditeurs de logiciels. D’autant plus qu’à la différence des noirs aux échecs, les cyberdéfenseurs ne peuvent pas contre-attaquer. Il est illégal pour un particulier ou une organisation de réagir en lançant une offensive informatique sur l’assaillant. Dans ce contexte, le plan de défense se décompose en trois parties : se protéger pour limiter l’initiative de l’agresseur, déployer une défense pour l’empêcher d’atteindre son objectif, et surtout assurer la résilience du système si l’attaquant parvient à son but.

Cette dernière éventualité ne peut pas être oubliée. « Historiquement, les chercheurs se sont rapidement rendu compte qu’ils n’arriveraient pas à empêcher toutes les attaques » rappelle Hervé Debar, chercheur en cybersécurité à Télécom SudParis. Du point de vue technique, « il est impossible de prévoir tous les chemins d’attaque possibles » insiste-t-il. Et sur le plan économique et organisationnel, bloquer toutes les portes de manière préventive ou en cas d’agression rend les systèmes inutilisables. Ainsi, il est souvent plus avantageux d’accepter de subir une attaque, d’y faire face et d’y mettre une fin, que de vouloir s’en prévenir absolument. Hervé Debar et Frédéric Cuppens, membres de la chaire Cybersécurité des infrastructures critiques de l’IMT (voir encadré en fin d’article), connaissent bien cet arbitrage. Pour des centrales nucléaires par exemple, il est inenvisageable de tout couper le temps de parer une menace.

Réduire l’initiative

Malgré ces entraves avec lesquelles doit composer la cyberdéfense, celle-ci n’est pas en retard pour autant. Les moyens techniques et financiers des organisations, qu’elles soient institutionnelles ou privées, sont généralement plus importants que ceux des cybercriminels — exception faite des attaques informatiques impliquant des États. Lorsqu’une nouvelle faille est découverte, elle est rapidement diffusée. « Les éditeurs de logiciels sont réactifs pour combler ces voies d’entrée, ça va très vite » assure Frédéric Cuppens. La National vulnerabilty database (NVD), est la base de données américaine recensant toutes les vulnérabilités connues. Pour les experts de la cyberdéfense, elle fait office de référence. De quelques centaines de failles comptabilisées en 1995, elle s’enrichit à présent de plusieurs milliers de nouvelles entrées chaque année — 15 000 pour l’année 2017. Signe de l’importance du partage de l’information pour réagir au plus vite, et de l’implication des communautés d’experts dans cette stratégie collective.

« Cela ne suffit pas » tempère Frédéric Cuppens. « Ces bases de données sont essentielles, mais elles sont toujours dans le coup d’après » précise-t-il. Pour réduire l’initiative des assaillants sur le moment, lorsque l’attaque a lieu, il faut d’abord la détecter le plus tôt possible. Le meilleur moyen d’y parvenir est d’adopter une approche comportementale. Pour cela, des données sont collectées et analysées sur le fonctionnement normal des systèmes. Une fois cette étape d’apprentissage réalisée, le comportement « naturel » du système est connu. Lorsqu’une déviation du fonctionnement par rapport à cette ligne de base est observée, c’est un signe potentiel de danger. « Sur des attaques de sites web par exemple, nous allons pouvoir détecter l’injection de commandes anormales qui trahissent l’action de l’attaquant » illustre Hervé Debar.

Les objets connectés, comme les caméras de surveillance, sont une nouvelle cible des attaquants. Il faut alors adapter la cyberdéfense en conséquence.

L’essor de l’internet des objets apporte un changement d’échelle qui réduit l’efficacité de cette approche comportementale, dans la mesure où il devient impossible de surveiller chaque objet individuellement. En 2016, le botnet Mirai prenait le contrôle de caméras de surveillance connectées et les utilisait pour envoyer des requêtes aux serveurs de la société Dyn. Résultat : Netflix, Twitter, Paypal et d’autres grands noms de l’internet dont le nom de domaine était géré par l’entreprise voyaient leurs sites inaccessibles. « Mirai a un peu changé les choses » reconnaît le chercheur de Télécom SudParis. Face aux vulnérabilités créées par les objets connectés, il faut adapter les protections. Il est inconcevable de surveiller des flottes entières de caméras comme on surveillerait un site web. Trop cher, trop difficile. « Nous protégeons donc les communications entre objets plutôt que les objets eux-mêmes, et nous donnons à certains un rôle spécifique de sentinelle » explique Hervé Debar. Parce qu’une attaque sur les caméras les touche toutes, il suffit d’en protéger et d’en observer quelques-unes pour détecter une intrusion globale. Le chercheur et son équipe ont ainsi démontré dans une collaboration avec Airbus que surveiller 2 capteurs industriels dans un groupe de 20 suffit à repérer une attaque.

Assurer la résilience

Une fois l’attaque détectée, tout doit être fait afin que celle-ci ait le moins d’incidence possible. « Pour entraver l’assaillant et récupérer l’initiative, une bonne solution est de faire du moving target defense [défense par déplacement de cible] » décrit Frédéric Cuppens. Cette technique est relativement nouvelle : les premiers travaux académiques sur le sujet datent du début des années 2010, et la pratique commence à se répandre dans les entreprises depuis deux ans environ. Elle consiste à déplacer les cibles de l’attaque dans des endroits plus sûrs. Dans le domaine du cloud, il est facile de comprendre cette stratégie de cyberdéfense. Les fonctions d’une machine virtuelle attaquée peuvent être déplacées vers une autre machine épargnée. Le service continue ainsi d’être assuré. « Avec ce moyen de défense, il suffit de reconfigurer dynamiquement les adresses IP et les fonctions de routage » décrit le chercheur d’IMT Atlantique. En somme, il s’agit d’orienter tout le trafic lié à un service vers un clone du système attaqué. Cette technique est un gros atout pour faire face à des attaques particulièrement sournoises. « Contre les maliciels polymorphes, qui se modifient en même temps qu’ils se propagent, la résilience des systèmes est primordiale » insiste Frédéric Cuppens.

Si le déplacement de cible est efficace pour les systèmes dématérialisés, il est plus difficile à déployer dans des infrastructures matérielles. Les robots connectés d’une ligne de production ou les flottes d’objets connectés ne peuvent pas être clonés et déplacés à la demande. Pour ces systèmes-là, c’est la diversification fonctionnelle qui est plutôt utilisée. « Pour un équipement qui fonctionne sur un certain matériel avec un certain logiciel, l’entreprise va reproduire le système mais avec un matériel et un logiciel différent » synthétise Frédéric Cuppens. Puisque les failles de sécurité sont inhérentes à un matériel ou logiciel donné, si l’un des deux équipements est attaqué, le second sera a priori toujours fonctionnel. Une telle protection a un coût. Face à cet argument, le chercheur rétorque qu’il en va de la sécurité des infrastructures et des personnes. « Dans un avion, nous acceptons tous que 80 % du coût soit dédié à la sécurité, car il y a de nombreuses vies en jeu. Pour les infrastructures c’est la même chose : perdre le contrôle de certains équipements peut coûter des vies, qu’il s’agisse de celles des employés à proximité ou des citoyens dans des cas extrêmes d’infrastructures critiques. »

Comment aller plus loin en cyberdéfense ?

Faire évoluer les mentalités vis-à-vis de la cybersécurité est un des grands défis à venir pour limiter encore plus les marges de manœuvres des attaquants. Convaincre les entreprises de l’importance d’investir dans le domaine en est une des composantes. Une autre est la diffusion des bonnes pratiques. « Aujourd’hui nous savons quels usages permettent d’assurer une meilleure sécurité dès la phase de développement des logiciels et des systèmes » assure Hervé Debar. Et de citer tout de go « utiliser des langages plus robustes que d’autres, des outils permettant de vérifier l’écriture des programmes, des librairies éprouvées pour certains fonctions, des patrons de programmation sécurisés, prévoir des plans de test… » Or ces pratiques sont encore loin d’être des réflexes pour les développeurs. Trop souvent encore, leur objectif est de proposer le plus rapidement possible une application ou un système fonctionnel, au détriment de la sécurité et de la robustesse.

Il devient pourtant critique de revoir ce paradigme. L’arrivée de l’intelligence artificielle pose de nombreuses questions. Si elle est une opportunité pour concevoir des solutions de détection d’intrusion qui sont dynamiques, elle ouvre aussi la porte à de nouvelles menaces. « Le principe du recours à l’IA c’est l’adaptation aux situations » problématise Frédéric Cuppens. « Mais si le système s’adapte en permanence, comment différencier en amont si les changements sont causés par l’IA ou par une attaque ? » Pour se prémunir d’une exploitation de cette zone grise par les cybercriminels, il faut être certain de la sécurité des systèmes, et transparent sur leur fonctionnement. Or aujourd’hui, ces deux dimensions sont bien loin d’être au cœur des considérations de la majorité des développeurs. « La sécurité des objets connectés est laissée pour compte » regrette Frédéric Cuppens. Plus que des questions de processus, « faire attention à ce que l’on fait en informatique est un état d’esprit » complète Hervé Debar.

[divider style= »normal » top= »20″ bottom= »20″]

Une chaire pour protéger les infrastructures critiques

Une chaire pour protéger les infrastructures critiques

Télécommunications, défense, énergie… Ces secteurs sont vitaux pour le bon fonctionnement du pays. En cas de défaillance, des services essentiels aux citoyens ne sont plus assurés. Avec l’essor des objets connectés au sein de ces infrastructures dites critiques, le risque de cyberattaque s’accroit. Il faut donc développer de nouveaux systèmes de cyberdéfense pour les protéger. C’est tout l’objet de la chaire Cybersécurité des infrastructures critiques de l’IMT. Elle allie les chercheurs d’IMT Atlantique, Télécom SudParis et Télécom Paristech autour de cette problématique. Les scientifiques travaillent en étroite collaboration avec des industriels directement concernés par ces questions. Airbus, Orange, EDF, La Poste, BNP Paribas, Amossys et Société générale sont ainsi partenaires de la chaire. Ils fournissent aux chercheurs des cas concrets de risques et de systèmes à protéger pour améliorer l’état de l’art en cyberdéfense.

[divider style= »normal » top= »20″ bottom= »20″]

Trackbacks (rétroliens) & Pingbacks

[…] Cyber defence wants to take the initiative – IM Tech […]

[…] La cyberdéfense veut reprendre l’initiative – IM Tech […]

[…] La cyberdéfense veut reprendre l’initiative […]

[…] La cyberdéfense veut reprendre l’initiative […]

[…] La cyberdéfense veut reprendre l’initiative […]

[…] La cyberdéfense veut reprendre l’initiative […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !