Quelles preuves de confiance en informatique ?

Le 10 mai, Maryline Laurent, chercheuse en informatique à Télécom SudParis intervient dans le cadre des petits-déjeuners de la Fondation Télécom sur la confiance à l’ère numérique. Elle s’interroge sur la façon dont celle-ci se décline en informatique, ainsi que sur la confiance distribuée dans le système de blockchain.

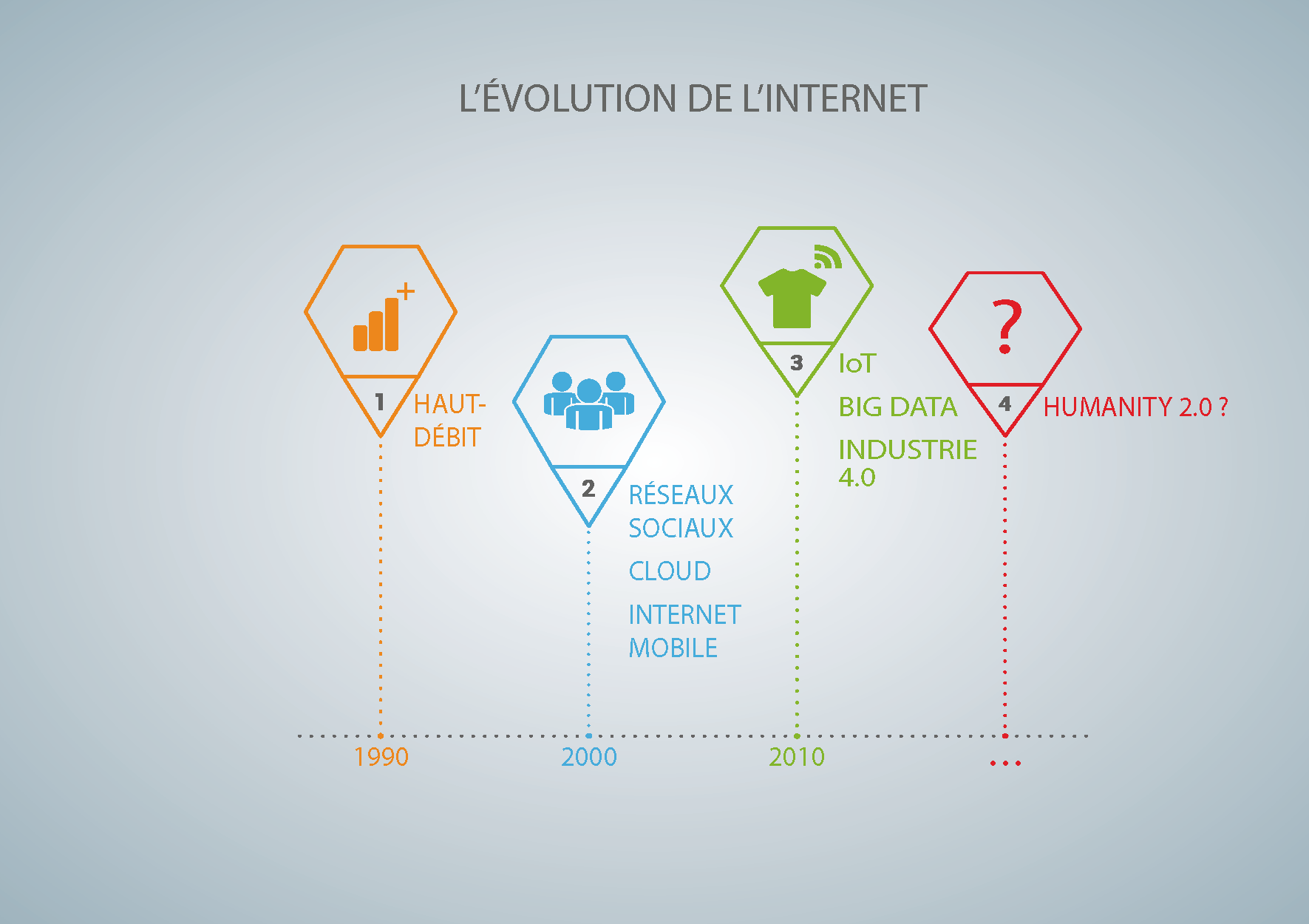

Maryline Laurent, co-fondatrice de la chaire Valeurs et politiques des informations personnelles, s’intéresse aux problématiques de sécurité et de protection des données personnelles dans différents contextes (cloud, IoT…). À l’occasion du petit-déjeuner de la Fondation Télécom sur le thème « Que reste-t-il de la confiance à l’ère du numérique ? », la chercheuse de Télécom SudParis expose en avant-première plusieurs réflexions qui seront également abordées dans le 2nd cahier de la chaire VPIP à venir en septembre 2017.

La confiance numérique est un concept très large, quel a été votre point d’entrée dans cette thématique ?

Maryline Laurent : L’idée première était de définir ce qu’est la confiance en informatique. Cela m’a amenée à traiter des preuves de confiance dans ce domaine et de leur évolution. J’ai identifié deux grands axes. Le premier concerne les approches encadrées par les institutions. Par exemple en Europe ce sera la Commission Européenne. Il s’agit d’une approche top-down. A partir de règlementations françaises ou européennes, des certifications ressortent et permettent de certifier des prestataires de services, des logiciels ou du matériel. La finalité est de produire de la confiance pour encourager les citoyens, les entreprises et les administrations à les utiliser. Le deuxième axe s’appuie sur les techniques d’analyse comportementale.

Quelles sont les différentes applications de l’analyse comportementale que vous avez identifiées ?

ML : Dans toutes les analyses comportementales, il y a le point commun de vouloir produire un score. Celui-ci mesure la distance entre le comportement mesuré et un comportement référence. Pour établir cette note, je me suis posé plusieurs questions : qui évalue qui ou quoi ? Et qui définit le comportement référence ?

Premier cas de figure, un être humain peut évaluer un service de vente en ligne, une autre personne qui lui a vendu quelque chose, un service de restauration, etc. Dans ce contexte, la norme est définie par la société. Selon nos propres critères, nous sommes satisfaits ou non de la prestation. Enfin, la valeur du score, qui est ici un indicateur de confiance, est le nombre de personnes qui ont contribué à le produire. Si nous voyons 5 recommandations clients, cela ne nous renseigne pas vraiment sur la qualité, mais s’il y en a 1 millier, alors ce score nous paraît plus représentatif de la qualité du service proposé. D’une façon générale, plus le volume de données disponibles est important, plus le résultat d’une analyse comportementale est de qualité.

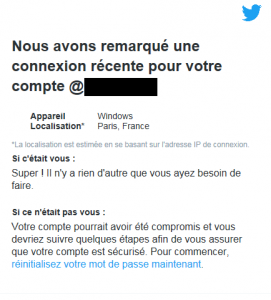

Autre cas de figure. Un individu peut être évalué par un algorithme, par exemple en vue de renforcer son niveau d’authentification auprès d’une plateforme. Chaque individu a des habitudes de géolocalisation et d’utilisation d’applications à certaines heures de la journée. Ces informations le qualifient en quelque sorte. Les algorithmes peuvent ainsi identifier si le comportement au moment de l’authentification correspond aux habitudes de la personne. C’est donc le comportement standard de l’individu qui sert de référence.

Je me suis amusée à pousser plus loin cette analyse en m’intéressant à une norme établie par un gouvernement dans le cas d‘une analyse comportementale menée sur des individus par un algorithme. Par exemple, l’État chinois est en train de travailler sur un nouveau service de « crédit social ». Celui-ci pourrait être mis en œuvre en 2020. L’idée serait de « scorer » tous les citoyens chinois selon leurs agissements. Les données collectées sur chaque individu sont dans ce cas comparées à un comportement de « bon citoyen » défini par l’État. Ceux s’éloignant trop de ce dernier se verraient pénaliser dans leur avancement de carrière, leurs choix de vie… L’analyse comportementale est ici réalisée à des fins de surveillance et pour dissuader les citoyens les plus revendicatifs.

Je me suis amusée à pousser plus loin cette analyse en m’intéressant à une norme établie par un gouvernement dans le cas d‘une analyse comportementale menée sur des individus par un algorithme. Par exemple, l’État chinois est en train de travailler sur un nouveau service de « crédit social ». Celui-ci pourrait être mis en œuvre en 2020. L’idée serait de « scorer » tous les citoyens chinois selon leurs agissements. Les données collectées sur chaque individu sont dans ce cas comparées à un comportement de « bon citoyen » défini par l’État. Ceux s’éloignant trop de ce dernier se verraient pénaliser dans leur avancement de carrière, leurs choix de vie… L’analyse comportementale est ici réalisée à des fins de surveillance et pour dissuader les citoyens les plus revendicatifs.

Un autre exemple : un algorithme peut évaluer massivement un groupe d’individus non ciblés ou des sites web. On ne s’intéresse plus à un individu en particulier mais l’algorithme considère une masse d’individus dont le comportement est comparé en temps réel à un comportement suspect établi par un État. La loi du renseignement en France s’appuie sur ce principe pour lutter contre le terrorisme. Suivant notre comportement de navigation sur Internet, l’algorithme peut détecter une attitude suspecte. Pour faire simple, si l’individu fait une succession de visites sur des sites dits déviants, alors il sera répertorié comme potentiellement suspect. C’est toujours du profilage mais à des fins de cyber-surveillance de masse.

Ce procédé s’applique également à l’évaluation massive des contenus hébergés sur des plateformes afin de détecter s’ils sont répréhensibles. Ce travail peut difficilement être réalisé manuellement par des modérateurs car le volume de données à traiter est trop important. Les plateformes ont donc recours, en plus du signalement des internautes vigilants, à des outils automatisés pour détecter des contenus problématiques. À charge pour les modérateurs de la plateforme de décider ensuite de la suppression ou non du contenu. Notons que Facebook a l’intention d’augmenter ses effectifs de modérateurs de 4500 à 7500. L’enjeu pour les plateformes est d’une part leur image vis-à-vis de leurs clients, mais aussi les peines encourues, plus ou moins lourdes suivant la législation des pays.

Et la confiance dans tout cela ?

ML : L’idée de renforcer le niveau d’authentification améliore la confiance. Même chose lorsque nous évaluons collectivement un service ou si un algorithme aide à identifier des contenus répréhensibles. A contrario, la surveillance et la cyber-surveillance améliorent la défiance ! Comme pour beaucoup de systèmes de sécurité, c’est à double tranchant. Il est possible d’utiliser les techniques d’analyse comportementale avec une finalité positive ou controversée.

Vous vous intéressez également à la confiance distribuée comme le système blockchain, pourquoi les utilisateurs ont-ils confiance en ce modèle ?

ML : Sans aller jusqu’à gagner la confiance des utilisateurs, on peut aujourd’hui dire que ce système suscite beaucoup de curiosités. Cela est lié au fait qu’il pourrait répondre à un besoin de confiance. Cette dernière est apportée par plusieurs éléments. Tout d’abord, la transparence. Un utilisateur peut lire les règles de gouvernance de la blockchain qui assurent son fonctionnement, mais aussi la liste de toutes les transactions qui sont enregistrées. Ainsi, il est important de se renseigner sur ces règles et les acteurs impliqués avant de rejoindre une blockchain. Un point essentiel à ce système est que tout est tracé et peut être audité pour vérifier l’authenticité et la validité des transactions. Appuyée par des outils et matériels cryptographiques forts, cette transparence engendre de la confiance car rien n’est caché à l’utilisateur.

Un autre concept essentiel qui vient en support à la confiance est le caractère entièrement décentralisé de la blockchain. En effet, chaque décision est prise par consensus, qu’il s’agisse d’un changement de règles de gouvernance ou de la validation d’une simple transaction. Tout n’est pas entre les mains d’une personne ou d’un organisme.

Existe-t-il des revers à la blockchain qui pourraient altérer la confiance de ses utilisateurs ?

ML : Si l’on regarde dans le détail, un utilisateur a intérêt à se poser plusieurs questions notamment sur la gouvernance. La neutralité de celle-ci est-elle garantie ? Les acteurs impliqués sont-ils réellement indépendants dans leurs prises de décision ? Si ce n’est pas le cas, le principe fondamental du « décentralisé » n’est plus respecté, tout comme celui de consensus. Des dérives sont alors possibles, avec des changements de règles de gouvernance pouvant aboutir à la mort brutale de la blockchain, alors que certaines personnes auraient pu y investir un certain capital.

Autre point, la répartition des ressources informatiques utiles aux calculs et au stockage dans une blockchain doit être équilibrée. Si plus de 50% de la puissance de calcul sont détenus par une seule organisation, alors la blockchain n’est plus équilibrée et il y a un risque fort que des transactions soient refusées. Finalement, la confiance est assurée si l’on reste dans une utilisation un peu utopiste de la blockchain.

[box type= »shadow » align= » » class= » » width= » »]

Les recherches actuelles de Maryline Laurent (Télécom SudParis)

Maryline Laurent anime depuis plusieurs années des recherches sur les problématiques de sécurité et de protection des données personnelles.

Maryline Laurent anime depuis plusieurs années des recherches sur les problématiques de sécurité et de protection des données personnelles.

Actuellement, elle s’intéresse à plusieurs problématiques telles-que « Comment mesurer si une base de données bénéficie d’un niveau d’anonymisation correct ? ». Cette recherche menée avec un doctorant en informatique d’Orange Labs, consiste en la définition d’une métrique permettant de comparer des techniques d’anonymisation et plusieurs instanciations de ces techniques entre elles.

Dans le cadre de la chaire VPIP, la chercheuse consacre également une partie de ses recherches à l’utilisation de la blockchain pour la protection des données personnelles des usagers. L’objectif est qu’une entreprise ne puisse pas utiliser ces informations au-delà du consentement. La blockchain servirait en quelque sorte de registre. Elle permettrait lors d’un audit a posteriori de vérifier qu’une entreprise n’outrepasse pas ses droits.

[/box]

[box type= »shadow » align= » » class= » » width= » »]La Fondation Télécom et l’IMT ont lancé conjointement, le 1er mars dernier, un cycle d’événements sur la confiance à l’ère numérique. Celui-ci débouchera sur un cahier de veille à l’été 2017. En savoir +[/box]

Trackbacks (rétroliens) & Pingbacks

[…] Quelles preuves de confiance en informatique ? […]

[…] Maryline Laurent, co-fondatrice de la chaire Valeurs et politiques des informations personnelles, s’intéresse aux problématiques de sécurité et de protection des données personnelles dans différents contextes (cloud, IoT…). À l’occasion du petit-déjeuner de la Fondation Télécom sur le thème « Que reste-t-il de la confiance à l’ère du numérique ? », la chercheuse de Télécom SudParis expose en avant-première plusieurs réflexions qui seront également abordées dans le 2nd cahier de la chaire VPIP à venir en septembre 2017. [Lire la suite] […]

[…] > Voir le contenu de l’intervention de Maryline Laurent sur le blog de l’IMT […]

Laisser un commentaire

Rejoindre la discussion?N’hésitez pas à contribuer !