Faire « revivre » les morts à partir de leurs emails, SMS ou autres traces de conversations laissées de leur vivant ? Ce fantasme ne relève plus seulement de la fiction d’un épisode de Black Mirror, la série d’anticipation à succès, mais bien de ce qu’un modèle de langage est désormais en capacité de faire. Dans un quotidien moins ésotérique, les modèles de langage ne remplacent pas les humains mais simplifient grandement une multitude de tâches, comme la prise de note, la synthèse de texte, la formulation d’emails, ou encore le codage et la programmation.

Sous les feux des projecteurs depuis ChatGPT, les grands modèles de langage (large language models en anglais, LLM) sont des algorithmes d’apprentissage automatique qui exécutent du traitement de langage naturel. Concrètement, ils sont entraînés sur des ensembles de données massives et modélisent statistiquement la distribution d’unités linguistiques – lettres, phonèmes, mots – dans une langue naturelle. Cette opération leur permet ensuite de reconnaître, traduire, prédire et générer des textes de manière fluide et contextuelle.

« Gardons-nous de trop céder à la tentation de la généralisation » (Alain Decaux)

Les LLM se heurtent néanmoins à des limites, notamment pour la gestion et le stockage d’informations précises, non probabilisées. En effet, l’apprentissage automatique derrière les modèles généralise, mais ne mémorise pas. Un système entraîné, par exemple, sur des images de chats est capable, par généralisation, de reconnaître un nouveau chat sur une image qu’il n’a jamais vue. « En revanche, dans le cas d’éléments matériels précis, par exemple les vis utilisées pour la fabrication d’un avion, cette généralisation n’est pas pertinente, voire pas souhaitable du tout », argumente Fabian Suchanek, chercheur en traitement du langage naturel à Télécom Paris. « Si on lui présente une vis pour savoir si elle est utilisée dans ce même avion, on ne veut pas que le système le confirme parce que des vis similaires le sont ». De fait, même en les entraînant sur une notice montrant toutes les vis de l’avion, les LLM ne sont pas capables de lister les vis, de les dénombrer ou encore d’en donner le poids…

La mise à jour de ces informations est en outre très compliquée : « Si une des vis de l’avion est remplacée, il est difficile d’enseigner au modèle de langage d’oublier l’ancienne, et il n’y a pas de garantie que ce dernier prenne en compte le changement », complète le chercheur. Enfin, les LLM sont des modèles lourds avec une forte empreinte carbone. Pour une requête simple – comme la détermination des pièces pouvant se connecter à un câble donné – un LLM requiert des processeurs graphiques et de la puissance de calcul pour faire tourner des milliards de paramètres, alors que la même requête sur une base de données ne prend que quelques nanosecondes avec un ordinateur quelconque.

L’idéale symbiose du « quoi » et du « comment »

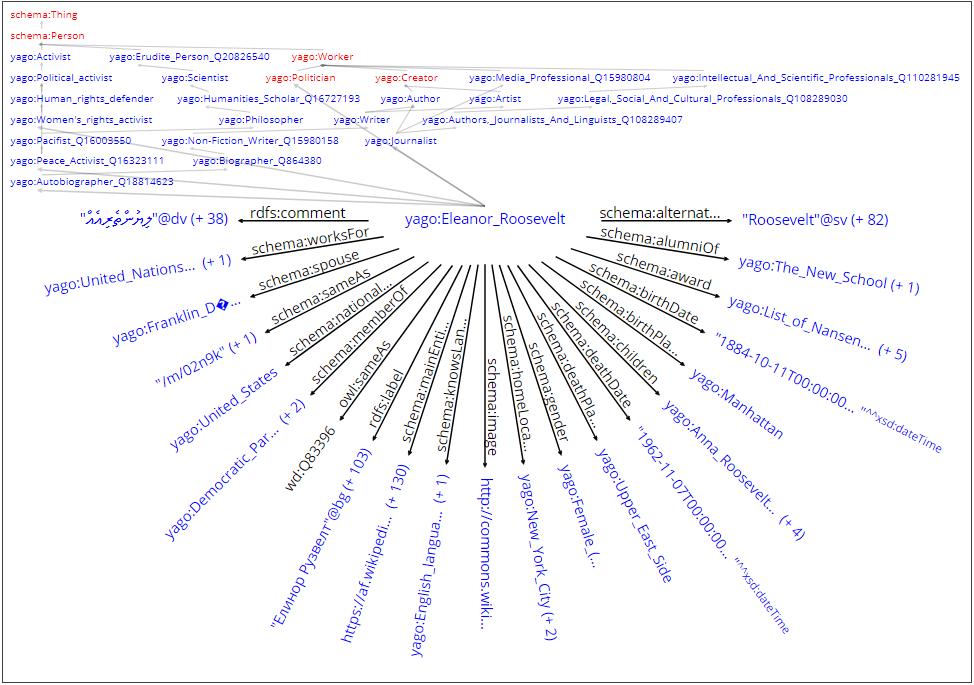

En effet, si les LLM ont une bonne compréhension du langage humain, les données structurées – des bases de données (comme XML ou Json) ou des bases de connaissance – stockent mieux l’information précise. Les bases de données, d’une part, se prêtent au stockage d’un ensemble exhaustif d’informations, comme par exemple, le listing des pièces d’un avion. Les bases de connaissance, d’autre part, se prêtent plutôt à des données incomplètes – des informations sur des personnages historiques par exemple, pour lesquelles l’exhaustivité est impossible. S’il fallait le résumer, les données structurées savent bien « quoi » répondre, là où les modèles de langage savent mieux « comment » répondre ; chaque approche ayant ses propres champs d’application.

La combinaison de ces deux approches présenterait donc un intérêt certain. En s’adossant à des données structurées, les LLM outrepasseraient la plupart des limites précédemment citées. Exactitude de l’information, facilité de mise à jour, ainsi qu’un allégement (du fait que les modèles stockeraient beaucoup moins de données) permettant de réduire leur empreinte carbone. « Les modèles plus petits sont également plus faciles à gérer localement, ce qui répondrait à des questions de souveraineté numérique », ajoute Fabian Suchanek. C’est là que la base de connaissances YAGO, dont il est le principal auteur, trouve sa raison d’être.

Naissance d’une autre grande base de connaissances

En 2008, alors qu’il est encore en thèse à l’institut Max-Planck, Fabian Suchanek fait partie des pionniers, avec ses co-auteurs, à construire une base de connaissance de façon automatique, à partir des données du net. C’est la naissance du projet YAGO, Yet Another Great Ontology. Depuis lors, un très grand nombre de bases de connaissances ont fait leur apparition, dont la plupart sont spécifiques, limitées à la représentation de concepts dans des domaines donnés (géographie, médecine, chimie…), voire dédiées à un champ d’application précis dans un domaine.

Dans ce paysage, YAGO est à l’inverse, une base généraliste très large car elle aspire les données du net, et plus précisément, au départ, celles de Wikipédia. Lorsque le projet a pris de l’ampleur, YAGO est devenu multilingue et les auteurs se sont intéressés à Wikidata, une autre grande base de connaissances. Créée en 2012, Wikidata a rencontré un vif succès à partir de la deuxième moitié des années 2010, ce qui a achevé de convaincre les créateurs de YAGO de l’utiliser comme ressource.

De la difficulté d’ordonner les données

Les bases de connaissances représentent les informations sous forme de graphe : les nœuds représentent des concepts ou des entités (des personnes, des lieux…), et les arrêtes des relations entre ces nœuds. Cette structure est organisée selon un schéma, qui propose une taxonomie, une hiérarchie de classes – par exemple, une capitale est une ville, une ville est un lieu… – ainsi qu’une définition formelle des types de relation entre les nœuds : « est-né-à », « travaille-chez », etc.

Comme son projet sœur Wikipédia, Wikidata bénéficie d’une large communauté de dizaines de milliers d’internautes qui contribue activement à sa structuration. Or si 20 000 personnes peuvent tomber d’accord sur un fait, comme une date de naissance, il est en revanche très complexe de toutes les faire s’aligner sur une taxonomie ou l’organisation de données. « C’est là où se situe notre force car nous ne sommes que six auteurs », explique Fabian Suchanek. « Et que notre astuce a été de conformer les données des bases « Wiki » à un schéma et une taxonomie propres, en provenance de ressources comme WordNet dans un premier temps, puis Schema.org ».